Architecte de vos plateformes/produits et agitateur de séries temporelles

Conception, développement, déploiement et exploitation de vos plateformes, applications et données.

Contactez-nous !Warp 10 - Interactions avec une instance InfluxDB

warp10 timeseries influxdb warpscript warpfleetAprès les premiers pas avec Warp10 et en attendant que l’extension FLoWS soit disponible pour la version 2.7.0, j’ai mis à jour mon instance Warp 10 en 2.7.0 et j’ai voulu jouer avec l’extension warp10-ext-influxdb. Cette extension permet de requêter une instance InfluxDB 1.x ou 2.x avec du WarpScript.

Attention à ne pas confondre le plugin natif InfluxDB qui permet d’envoyer des métriques au format Line Protocol d’InfluxDB dans Warp10 et l’extension InfluxDB qui permet d’interagir avce une base InfluxDB en WarpScript.

Pré-requis: warpfleet

Installons déjà warpfleet, le gestionnaire de package conçu pour Warp 10.

# Installation de npm

sudo dnf install -y npm

# installation de warpfleet

sudo npm install -g @senx/warpfleet

# Vérification de la bonne installation de warpfleet

wf version

___ __ _______________ _____

__ | / /_____ __________________ ____/__ /___________ /_

__ | /| / /_ __ `/_ ___/__ __ \_ /_ __ /_ _ \ _ \ __/

__ |/ |/ / / /_/ /_ / __ /_/ / __/ _ / / __/ __/ /_

____/|__/ \__,_/ /_/ _ .___//_/ /_/ \___/\___/\__/

/_/ ™

version: 1.0.31

1.0.31

Installation de l’extension warp10-ext-influxdb

Sans trop rentrer dans les détails de warpfleet, il utilise un système de namespace appelés “Groups” pour ces packages et qui permettent de définir ses propres dépots. Pour l’extension warp10-ext-influxdb, le “group” est io.warp10.

Ce qui pour l"installation donne la commande suivante :

# Si votre utilisateur n'a pas accès à /path/to/warp10, il vous faudra utiliser sudo

(sudo) wf g -w /path/to/warp10 io.warp10 warp10-ext-influxdb

warpfleet va vous demander quelle version de l’extension vous souhaitez puis va procéder à son téléchargement et son installation.

Cela donne :

sudo wf g -w /opt/warp10 io.warp10 warp10-ext-influxdb

___ __ _______________ _____

__ | / /_____ __________________ ____/__ /___________ /_

__ | /| / /_ __ `/_ ___/__ __ \_ /_ __ /_ _ \ _ \ __/

__ |/ |/ / / /_/ /_ / __ /_/ / __/ _ / / __/ __/ /_

____/|__/ \__,_/ /_/ _ .___//_/ /_/ \___/\___/\__/

/_/ ™

version: 1.0.31

? Which revision do you want to retrieve? latest

✔ ext io.warp10:warp10-ext-influxdb#1.0.1-uberjar retrieved

✔ Download successful: gradle-wrapper.jar

✔ Download successful: gradle-wrapper.properties

✔ Download successful: gradlew

✔ Download successful: gradlew.bat

✔ Dependency warp10-ext-influxdb-1.0.1-uberjar.jar successfully deployed

✔ Done

Note: Pour éviter un bug dans la fonction INFLUXDB.UPDATE identifié lors de la rédaction de ce billet, assurez-vous d’avoir une version >= 1.0.1

Ensuite, il faut créer le fichier /path/to/warp10/etc/conf.d/90--influxdb-extension.conf et y ajouter la ligne suivante:

warpscript.extension.influxdb = io.warp10.script.ext.influxdb.InfluxDBWarpScriptExtension

Je préfère créer un fichier plutôt que d’éditer un fichier existant pour le suivi des mises à jour et j’ai utilisé le prefix 90 car il n’est pas utilisé par les fichiers de Warp10.

Relancer ensuite Warp 10 pour que le plugin soit chargé au démarrage de l’instance :

(sudo) /path/to/warp10/bin/warp10-standalone.init restart

Dans /path/to/warp10/logs/warp10.log, vous devriez voir apparaitre :

2020-09-17T10:59:23,742 main INFO script.WarpScriptLib - LOADED extension 'io.warp10.script.ext.influxdb.InfluxDBWarpScriptExtension'

Requêtage d’une instance InfluxDB 1.x

Note: La librairie influxdb-java ne semble pas supporter un reverse proxy http/2 devant l’instance InfluxDB. Il faut donc accéder à InfluxDB en direct via le port 8086.

# Requête INFLUXQL et informations de connection à InfluxDB 1.X

{ 'influxql' "select * from cpu where host=%27myHost%27 and time > now() - 1h" 'db' "myDatabase" 'password' "myPassword" 'user' "myUser" 'url' "http://url.to.influxdb:8086" }

INFLUXDB.FETCH

# On récupère une liste de liste de séries GTS. Il n'y a qu'un seul élément dans cette liste. Nous le prenons pour n'avoir plus qu'une liste de séries GTS.

0 GET

# Sauvegarde de la liste dans une variable cpu

'cpu' STORE

# Affichage de la liste de GTS

$cpu

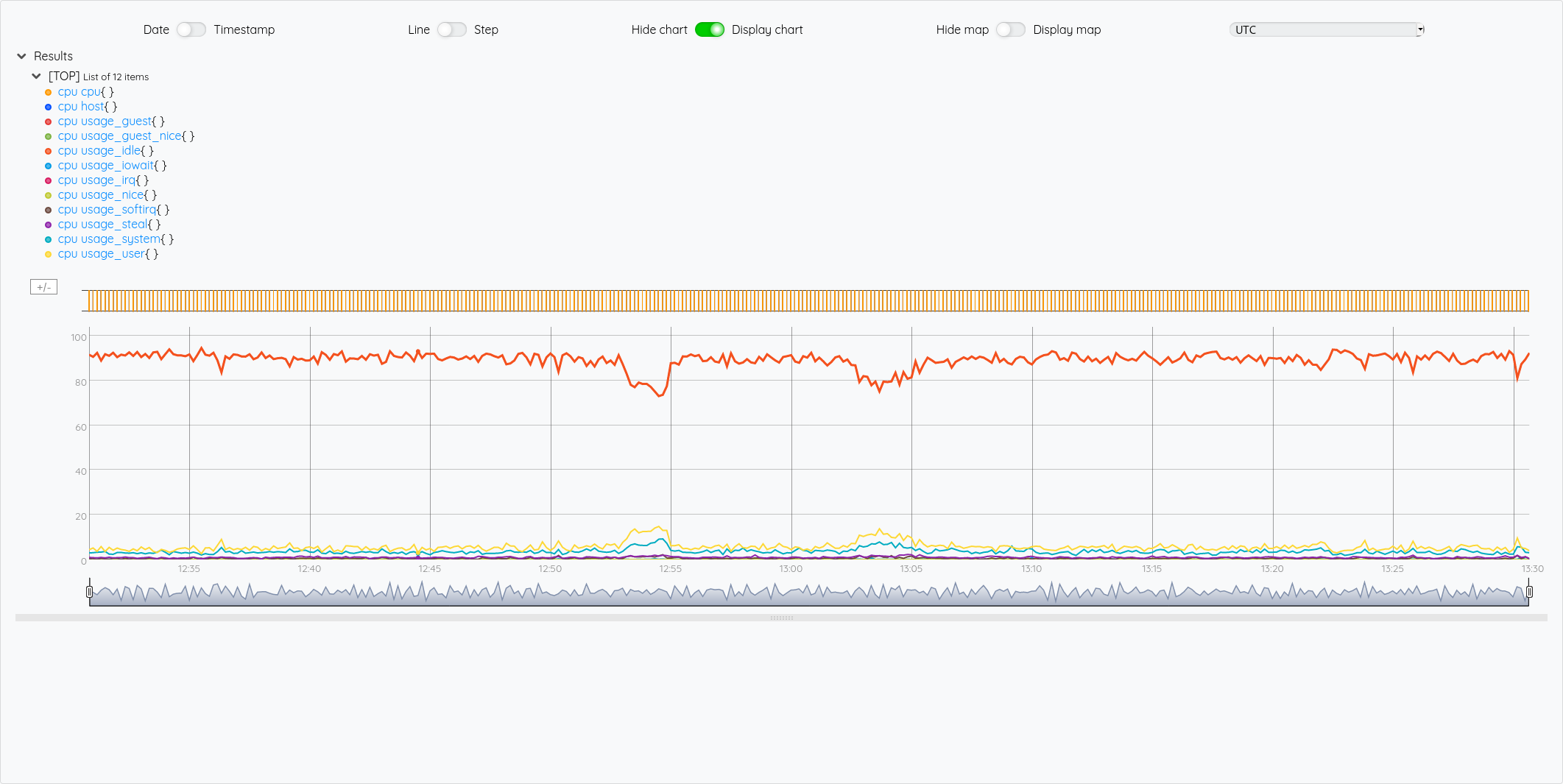

Dans ce qu’il faut noter ici:

INFLUXDB.FETCHprend ses paramètres dans une MAP ayant pour paramètres:influxql,db,password,usereturl.- Pour la directive where, il faut encoder les apostrophes via

%27: en InfluxQL, on écrirait... where host='myHost'; là, il faut écrirewhere host=%27myHost%27 - Si dans InfluxDB, on a un measurements (cpu) avec n items (usage_guest, usage_idle, etc), on a une conversion en une liste de n GTS avec une valeur chacune.

influxqlprend une ou plusieurs requêtes séparées par des points virgules. Cela donnera en sortie plusieurs listes de listes de GTS (vu que comme dit au dessus, pour une requête influxql sur un measurement on a 1 à n GTS ; donc pour y requêtes, on aura y listes de n listes de GTS)

Pour illustrer cette liste de liste de GTS, si on veut récupérer la GTS du cpu idle, on voit dans le graphique que c’est la 5ème courbe, donc un indice 4.

{ 'influxql' "select * from cpu where host=%27myHost%27 and time > now() - 1h" 'db' "myDatabase" 'password' "myPassword" 'user' "myUser" 'url' "http://url.to.influxdb:8086" }

INFLUXDB.FETCH

0 GET

'cpu' STORE

# Récupération de la 5ème liste (indice 4)

$cpu 4 GET

Requêtage d’une instance InfluxDB 2.x

Note: La librairie influxdb-client-java ne semble pas plus supporter un reverse proxy http/2 devant l’instance InfluxDB. Il faut donc accéder à InfluxDB en direct via le port 9999.

Si on fait une requête similaire en flux :

# Requête FLUX et informations de connection à InfluxDB 2.x

{ 'flux' "from(bucket: %22myBucket%22) |> range(start: -1h, stop: now()) |> filter(fn: (r) => r[%22_measurement%22] == %22cpu%22) |> filter(fn: (r) => r[%22cpu%22] == %22cpu-total%22) |> aggregateWindow(every: 1s, fn: mean, createEmpty: false) |> yield(name: %22mean%22)" 'org' "myOrganisation" 'token' "myToken" 'url' "http://url.to.influxdb2:9999" }

INFLUXDB.FLUX

# On récupère une liste de séries GTS

# Sauvegarde de la liste dans une variable cpu

'cpu' STORE

# Affichage de la liste de GTS

$cpu

On note que la requête flux n’est pas très lisible de par l’encodage des guillemets et de son coté monoligne. On peut améliorer ça avec une variable STRING en multi-ligne :

# Utilisation du string multi-ligne pour améliorer la lisibilité de la requête FLUX et sauvegarde dans une variable fluxquery.

<'

from(bucket: "crntbackup")

|> range(start: -1h, stop: now())

|> filter(fn: (r) => r["_measurement"] == "cpu")

|> filter(fn: (r) => r["cpu"] == "cpu-total")

|> aggregateWindow(every: 1s, fn: mean, createEmpty: false)

|> yield(name: "mean")

'>

'fluxquery' STORE

# Paramètres de la fonction INFLUX.FLUX avec la requête flux (la variable fluxquery) et les informations de connection à InfluxDB 2.x

{ 'flux' $fluxquery 'org' "myOrganisation" 'token' "myToken" 'url' "http://url.to.influxdb2:9999" }

INFLUXDB.FLUX

# Sauvegarde de la liste dans une variable cpu

'cpu' STORE

# Affichage de la liste de GTS

$cpu

On y gagne en lisibilité et pas besoin d’encoder les guillements !

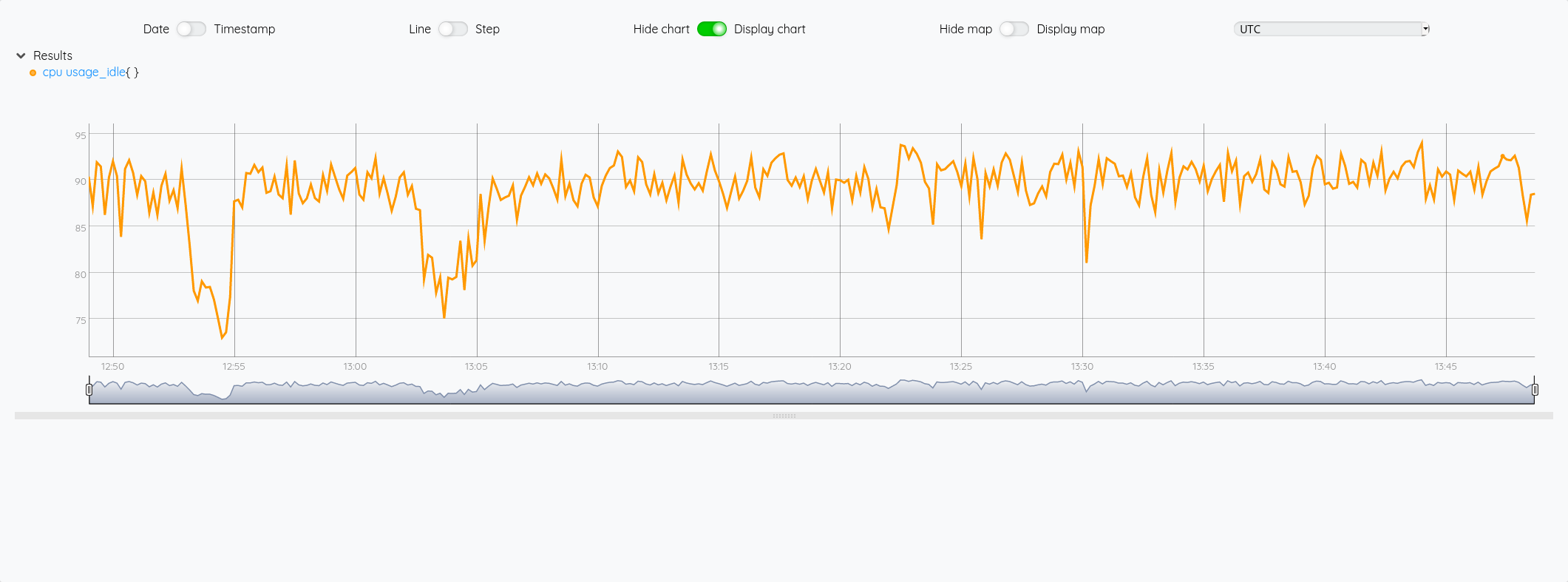

Dans les deux cas, on obtient :

On note d’ailleurs que les méta-données (nom du measurement, nom du champ et les tags sont repris sous la forme de labels)

Contraiement à la requête en InfluxQL, on ne peut passer qu’une requête à la fois mais ce qui permet d’avoir directment une liste de GTS puis la GTS. On n’a plus une liste de liste de GTS.

Si on veut comme précédemment avec InfluxQL afficher la courbe du CPU idle:

# Utilisation du string multi-ligne pour améliorer la lisibilité de la requête FLUX et sauvegarde dans une variable fluxquery.

<'

from(bucket: "crntbackup")

|> range(start: -1h, stop: now())

|> filter(fn: (r) => r["_measurement"] == "cpu")

|> filter(fn: (r) => r["cpu"] == "cpu-total")

|> aggregateWindow(every: 1s, fn: mean, createEmpty: false)

|> yield(name: "mean")

'>

'fluxquery' STORE

# Paramètres de la fonction INFLUX.FLUX avec la requête flux (la variable fluxquery) et les informations de connection à InfluxDB 2.x

{ 'flux' $fluxquery 'org' "myOrganisation" 'token' "myToken" 'url' "http://url.to.influxdb2:9999" }

INFLUXDB.FLUX

# Sauvegarde de la liste dans une variable cpu

'cpu' STORE

# Affiche la 7eme liste (incide 6)

$cpu 6 GET

Je ne vais pas pousser l’exemple plus loin, il ne tient qu’à vous de poursuivre la manipulation de vos données en WarpScript. On pourrait se demander où mettre la limite entre la requête en Flux/InfluxQL et les manipulations à faire en WarpScript ensuite. Tout dépendra de votre cas d’usage.

Sauvegarder des données dans InfluxDB

Pour le moment, nous avons requêté des données stockées dans InfluxDB 1.x ou 2.x ; mais nous pouvons très bien imaginer un cas où les données sont issues d’une autre source de données ou bien ont été générées avec WarpScript mais qu’on veuille les persister dans InfluxDB 1.x ou 2.x

Reprenons mon exercice de compatbilité et de prédictions et sauvegardons tout ça dans InfluxDB.

Pour rappel, nous avons fait ceci :

'<read_token>' 'readToken' STORE

'<wrtie_token>' 'writeToken' STORE

# Récupération des dépenses sous la forme d'une série (GTS)

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

# Récupération du chiffre d'affaires mensuel sous la forme d'une série (GTS)

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

# Calcul du résulat mensuel

$revenue $exp -

# Stockage de la série obtenue dans une série appelée "result"

"result" RENAME

{ "company" "cerenit" } RELABEL

$writeToken UPDATE

# Récupération du résultat mensuel sous la forme d'une série (GTS)

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

Si je veux sauvegarder une série dans un measurement influxdb :

# Version 1.x

# Création d'une MAP 'params' avec les informations de connection à l'instance InfluxDB

{ 'v1' true 'url' "http://url.to.influxdb:8086" 'measurement' "result" 'db' "crntcompta" 'password' "myPassword" 'user' "myUser" }

'params' STORE

# Utilisatoin de la fonction INFLUXDB.UPDATE qui prend la variable 'params' pour les paramètres de connection et une GTS ou liste de GTS pour les données à sauvegarder

$result $params INFLUXDB.UPDATE

# Version 2.x

# Création d'une MAP 'params' avec les informations de connection à l'instance InfluxDB

{ 'v1' false 'url' "http://url.to.influxdb:9999" 'measurement' "result" 'bucket' "crntcompta" 'token' "myToken" 'org' "myOrganisation" }

'params' STORE

$result $params INFLUXDB.UPDATE

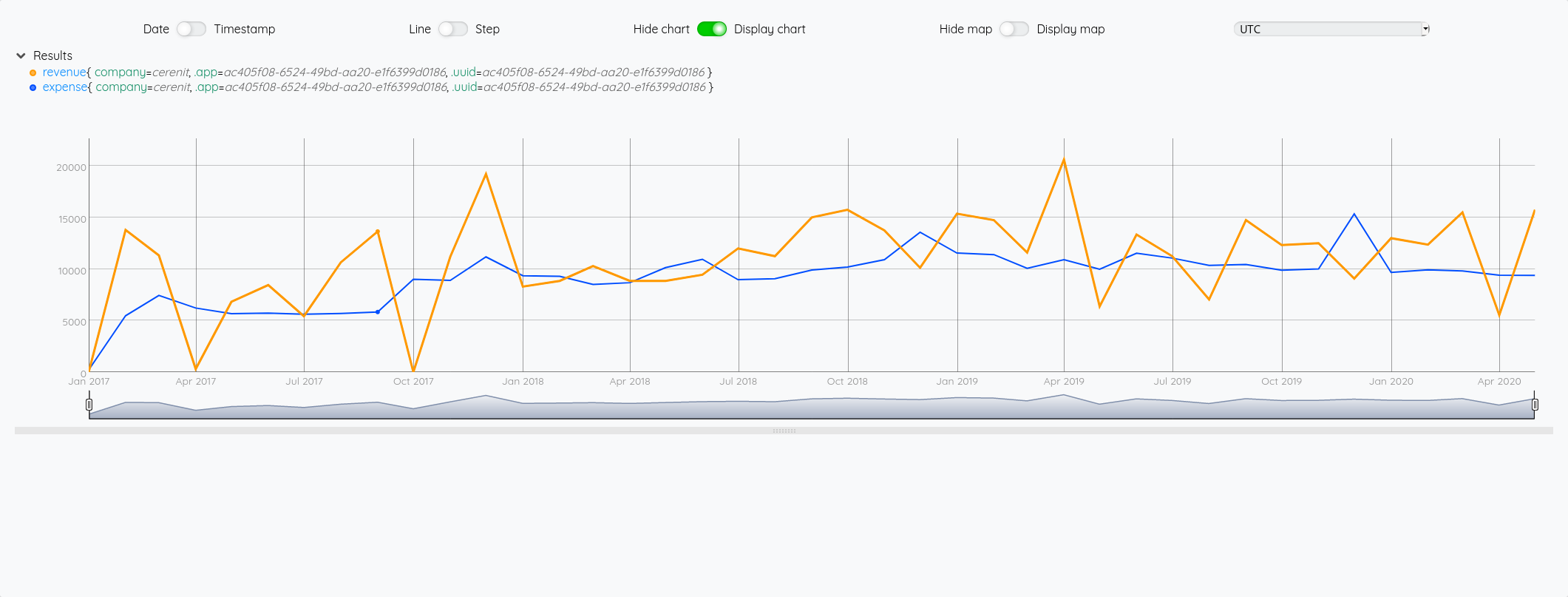

Coté InfluxDB, on retrouve bien nos données :

Si au contraire, je veux regrouper plusieurs valeurs dans un même measurement InfluxDB, il faut passer une liste de GTS à INFLUXDB.UPDATE.

# Version 1.x

# Création d'une MAP 'params' avec les informations de connection à l'instance InfluxDB

{ 'v1' true 'url' "http://url.to.influxdb:8086" 'measurement' "accountancy" 'db' "crntcompta" 'password' "myPassword" 'user' "myUser" }

'params' STORE

# Passage d'une liste de GTS plutôt qu'une seule série de l'expemple précédent

[ $result $revenue $exp ] $params INFLUXDB.UPDATE

# Version 2.x

# Création d'une MAP 'params' avec les informations de connection à l'instance InfluxDB

{ 'v1' false 'url' "http://url.to.influxdb:9999" 'measurement' "accountancy" 'bucket' "crntcompta" 'token' "myToken" 'org' "myOrganisation" }

'params' STORE

# Passage d'une liste de GTS plutôt qu'une seule série de l'expemple précédent

[ $result $revenue $exp ] $params INFLUXDB.UPDATE

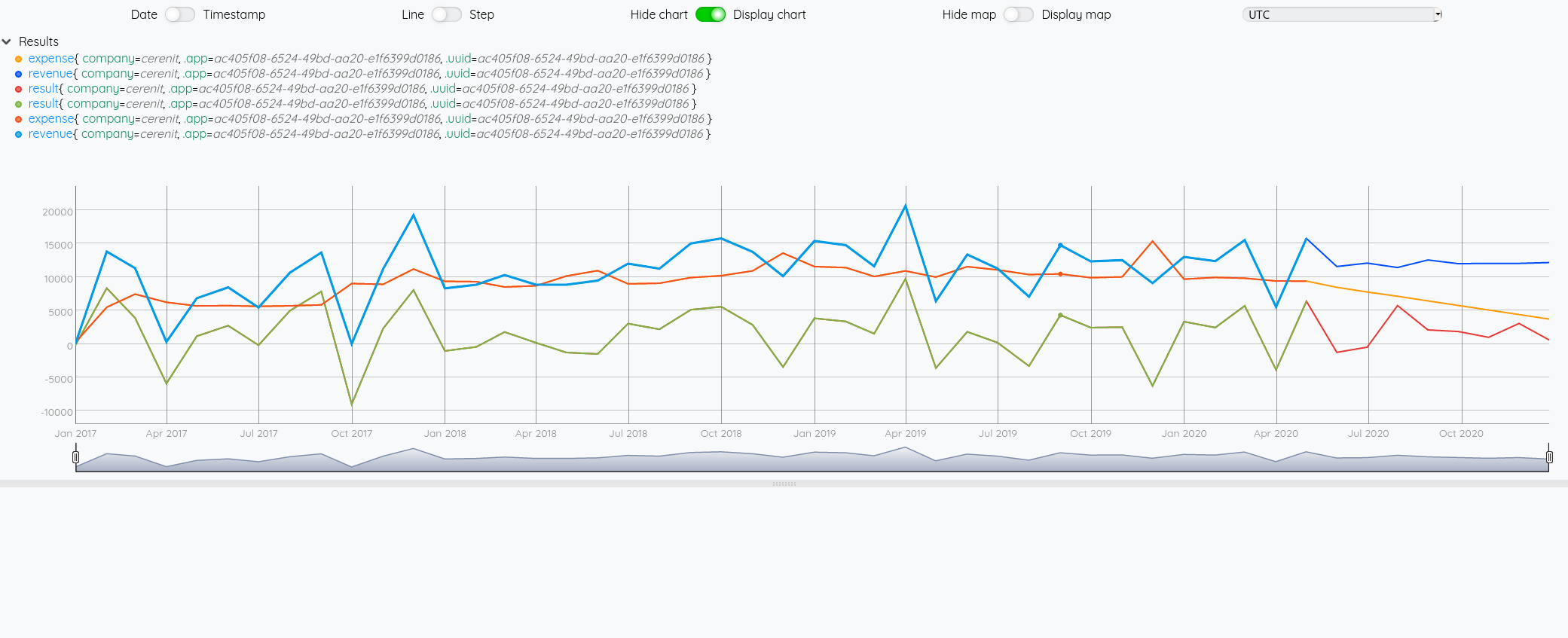

Coté InfluxDB, on retrouve bien nos données :

On arrive au bout de ce billet, nous avons vu que nous pouvons :

- En WarpScript, requêter des données stockées dans InfluxDB 1.x et 2.x

- En WarpScript, manipuler des données issues de Warp 10 puis les stocker dans InfluxDB 1.x et 2.x

Nous pourrions aller plus loin avec :

- des scénarios d’enrichissement de données en s’interfaçant par ex avec des données de sources SQL (référentiels, etc)

- des scénarios d’analytics en croisant des données issues de Warp10, InfluxDB ou d’autres sources de données (bases SQL, etc)

- des scénarios de projection en appliquant par exemple les algorythmes de machine learning sur des données issues d’InfluxDB

- …

WarpScript semble ainsi permettre d’avoir un langage de manipulation de séries temporelles multi-sources et d’offrir une expérience unifiée de manipulatoin de ces données. Dans les prochains billets, nous explorerons d’avantage la partie visualisation et alerting.

Premiers pas avec Warp 10 : comptabilité et prévisions de fin d'année

warp10 timeseries forecast dashboard warpstudio arimaSuite de notre épopée :

- Partie 1 - Premier pas avec Warp 10, comptabilité et prévisions de fin d’année (ce billet)

- Partie 2 - Remise à jour des données, comparaison des données prévues vs réelles, prévisions 2021

- Partie 3 - Récupération des données de la Sandbox dans notre instance locale

- Partie 4 - Dashboards

- Partie 5 - Les FEC et le compte 512

- Partie 6 - Les FEC et le compte de résultat

Cherchant à me familiariser avec la base de données orientée série temporelles Warp 10 d’une part et à améliorer mes tableaux de bord comptables pour me faire des projections à fin d’année (parce que bon, faire juste la moyenne des mois précédents comme valeur pour les mois à venir, c’est un peu trop facile), je me suis dit que c’était un exercice qui pouvait répondre aux deux besoins après avoir lu Time series forecasts in WarpScript.

Pour ceux qui ne connaissent pas encore Warp 10 , c’est une solution de geo-timeseries (séries spatio temporelles) open source, éditée par SenX, société française basée à Brest. Pour en savoir plus sur Warp 10 , vous pouvez regarder l’éditions 1 et l’édition 5 du Paris Time Series Meetup.

Pour prendre en main Warp 10 et appréhender le langage de programmation Warpscript, je vous invite à suivre le tutoriel sur les cyclones en utilisant la Sandbox Warp10 mise à disposition par Senx.

Le jeu de données

Pour le jeu de données, j’ai donc récupéré de mes tableaux de bords mon chiffre d’affaires et mes dépenses mensuels sur la période Janvier 2017 à Mai 2020.

Nous allons donc créer 2 séries (appelées aussi GTS)

Soit crnt-revenue.gts:

# 2017

1483225200000000// revenue{company=cerenit} 0

1485903600000000// revenue{company=cerenit} 13800

1488322800000000// revenue{company=cerenit} 11325

1490997600000000// revenue{company=cerenit} 300

1493589600000000// revenue{company=cerenit} 6825

1496268000000000// revenue{company=cerenit} 8450

1498860000000000// revenue{company=cerenit} 5425

1501538400000000// revenue{company=cerenit} 10650

1504216800000000// revenue{company=cerenit} 13650

1506808800000000// revenue{company=cerenit} 0

1509490800000000// revenue{company=cerenit} 11200

1512082800000000// revenue{company=cerenit} 19225

# 2018

1514761200000000// revenue{company=cerenit} 8300

1517439600000000// revenue{company=cerenit} 8850

1519858800000000// revenue{company=cerenit} 10285

1522533600000000// revenue{company=cerenit} 8850

1525125600000000// revenue{company=cerenit} 8850

1527804000000000// revenue{company=cerenit} 9450

1530396000000000// revenue{company=cerenit} 12000

1533074400000000// revenue{company=cerenit} 11250

1535752800000000// revenue{company=cerenit} 15013

1538344800000000// revenue{company=cerenit} 15750

1541026800000000// revenue{company=cerenit} 13750

1543618800000000// revenue{company=cerenit} 10125

# 2019

1546297200000000// revenue{company=cerenit} 15375

1548975600000000// revenue{company=cerenit} 14750

1551394800000000// revenue{company=cerenit} 11600

1554069600000000// revenue{company=cerenit} 20622

1556661600000000// revenue{company=cerenit} 6376

1559340000000000// revenue{company=cerenit} 13350

1561932000000000// revenue{company=cerenit} 11250

1564610400000000// revenue{company=cerenit} 7050

1567288800000000// revenue{company=cerenit} 14750

1569880800000000// revenue{company=cerenit} 12326

1572562800000000// revenue{company=cerenit} 12513

1575154800000000// revenue{company=cerenit} 9082

# 2020

1577833200000000// revenue{company=cerenit} 13000

1580511600000000// revenue{company=cerenit} 12375

1583017200000000// revenue{company=cerenit} 15500

1585692000000000// revenue{company=cerenit} 5525

1588284000000000// revenue{company=cerenit} 15750

et crnt-expenses.gts:

# 2017

1483225200000000// expense{company=cerenit} 219

1485903600000000// expense{company=cerenit} 5471

1488322800000000// expense{company=cerenit} 7441

1490997600000000// expense{company=cerenit} 6217

1493589600000000// expense{company=cerenit} 5676

1496268000000000// expense{company=cerenit} 5719

1498860000000000// expense{company=cerenit} 5617

1501538400000000// expense{company=cerenit} 5690

1504216800000000// expense{company=cerenit} 5831

1506808800000000// expense{company=cerenit} 9015

1509490800000000// expense{company=cerenit} 8903

1512082800000000// expense{company=cerenit} 11181

# 2018

1514761200000000// expense{company=cerenit} 9352

1517439600000000// expense{company=cerenit} 9297

1519858800000000// expense{company=cerenit} 8506

1522533600000000// expense{company=cerenit} 8677

1525125600000000// expense{company=cerenit} 10136

1527804000000000// expense{company=cerenit} 10949

1530396000000000// expense{company=cerenit} 8971

1533074400000000// expense{company=cerenit} 9062

1535752800000000// expense{company=cerenit} 9910

1538344800000000// expense{company=cerenit} 10190

1541026800000000// expense{company=cerenit} 10913

1543618800000000// expense{company=cerenit} 13569

# 2019

1546297200000000// expense{company=cerenit} 11553

1548975600000000// expense{company=cerenit} 11401

1551394800000000// expense{company=cerenit} 10072

1554069600000000// expense{company=cerenit} 10904

1556661600000000// expense{company=cerenit} 9983

1559340000000000// expense{company=cerenit} 11541

1561932000000000// expense{company=cerenit} 11065

1564610400000000// expense{company=cerenit} 10359

1567288800000000// expense{company=cerenit} 10450

1569880800000000// expense{company=cerenit} 9893

1572562800000000// expense{company=cerenit} 10014

1575154800000000// expense{company=cerenit} 15354

# 2020

1577833200000000// expense{company=cerenit} 9673

1580511600000000// expense{company=cerenit} 9933

1583017200000000// expense{company=cerenit} 9815

1585692000000000// expense{company=cerenit} 9400

1588284000000000// expense{company=cerenit} 9381

Pour chaque fichier:

- le premier champ est un timestamp correspondant au 1er jour de chaque mois à 00h00.

- la partie

//indique qu’il n’y a pas de position spatiale (longitude, lattitude, élévation) expenseetrevenuesont les noms des classes qui vont stocker mes informationscompanyest un label que je positionne sur mes données avec le nom de mon entreprise- le dernier champ est la valeur de mon chiffre d’affaires ou de mes dépenses mensuels.

Pour plus d’information sur la modélisation, cf GTS Input Format.

Insertion des données

Lorsque vous utilisez la Sandbox, 3 tokens vous sont donnés :

- un token pour lire les données ; j’y ferai référence via

<readToken>par la suite - un token pour écrire les données ; j’y ferai référence via

<writeToken>par la suite - un token pour supprimer les données ; j’y ferai référence via

<deleteToken>par la suite

#!/usr/bin/env bash

for file in crnt-expenses crnt-revenue ; do

curl -v -H 'Transfer-Encoding: chunked' -H 'X-Warp10-Token: <writeToken>' -T ${file}.gts 'https://sandbox.senx.io/api/v0/update'

done

Premières requêtes

Pour ce faire, nous allons utiliser le Warp Studio ; pour la datasource, il conviendra de veiller à ce que la SenX Sandbox soit bien sélectionnée.

L’équivalent de “SELECT * FROM *” peut se faire de la façon suivante :

# Authentification auprès de l'instance en lecture

'<readToken> 'readToken' STORE

# FETCH permet de récupérer une liste de GTS, ici on demande toutes les classes via ~.* et tous les labels en prenanr les 1000 dernières valeurs ; on récupère donc toutes les séries.

[ $readToken '~.*' {} NOW -1000 ] FETCH

Si vous cliquez sur l’onglet “Dataviz”, vous avez alors immédiatement une représentation graphique de vos points.

Maintenant que nos données sont bien présentes, on va vouloir aller un peu plus loin dans nos manipulations.

Premières manipulations

Ce que nous voulons faire :

- Sélectionner chaque série et la stocker dans une variable,

- Calculer le résultat mensuel et le persister dans une troisième série temporelle

- Afficher les trois séries.

Pour sélectionner chaque série et la stocker dans une variable:

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# FETCH : permet de récupérer une liste de série, ici on filtre sur la classe expense, sur le label company = cerenit et sur les dates du 01/12/2016 au 01/06/2020.

# 0 GET : on sait que l'on a qu'une seule série qui correspond à la requête. Donc on ne retient que le 1er élément pour passer d'une liste de GTS à une seule et unique GTS.

# STORE : stocke le résultat dans une variable exp.

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

# Idem pour la classe revenue, stockée dans une variable revenue.

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

# Affiche les 2 séries

$exp

$revenue

A ce stade, vous avez la même représentation graphique que précédemment si vous cliquez sur Dataviz.

Calculons maintenant le résultat mensuel (chiffre d’affaires - dépenses) :

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Le même bloc que précédemment

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

# Calcul: il suffit se soustraire les deux éléments pour avoir le résultat

$revenue $exp -

# on affiche également les deux autres variables pour la dataviz

$exp

$revenue

A ce stade :

- Au niveau de la dataviz, la légende ne fournit aucune information sur la nature de la série

- Cette donnée n’est pas encore persistée

Jusqu’à présent, nous avons utilisé que le <readToken> pour lire les données. Pour la persistence, nous allons utilier le <writeToken>.

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Authentification auprès de l'instance en écriture

'<writeToken>' 'writeToken' STORE

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

# La première ligne est inchangée, elle calcule le résultat mensuel et la donnée est de type GTS

# Du coup, comme nous sommes dans une pile et que l'on hérite de ce qu'il s'est passé avant, on peut lui assigner un nom via RENAME

# Puis lui ajouter le label company avec pour valeur cerenit

# Et utiliser la fonction UPDATE pour stocker en base la GTS ainsi obtenue.

$revenue $exp -

"result" RENAME

{ "company" "cerenit" } RELABEL

$writeToken UPDATE

# Comme pour revenue et expense, on récupère les données sous la forme d'une GTS que l'on stocke dans une variable

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

# On vide la pile

CLEAR

# On affiche les variables créées

$revenue

$exp

$result

Et voilà !

Prévoyons le futur

Warp10 dispose d’une extension propriétaire et payante permettant d’appliquer des algorithmes de prévisions sur des séries temporelles : warp10-ext-forecasting. Il est possible d’utiliser cette extension sur la Sandbox Warp10 mise à disposition par SenX.

Il existe une fonction AUTO et SAUTO (version saisonnière) qui applique automatiquement des algorythmes d’AutoML sur vos données.

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Récupération des trois séries

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

CLEAR

$revenue

$exp

$result

# MAP: la fonction `AUTO` s'attend à manipuler des nombres au format `DOUBLE` et non des entiers. Il faut donc faire la conversion.

# FORECAST: sur les données obtenues du MAP, on applique la fonction AUTO et on demande les 8 prochaines occurents (pour aller jusqu'à la fin d'année)

# Le .ADDVALUES permet de "fusionner" les prévisions avec la série parente (sans les persister en base à ce stade)

# Commes les 3 projections sont disponibles dans la pile, elles sont également affichées

[ $result mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

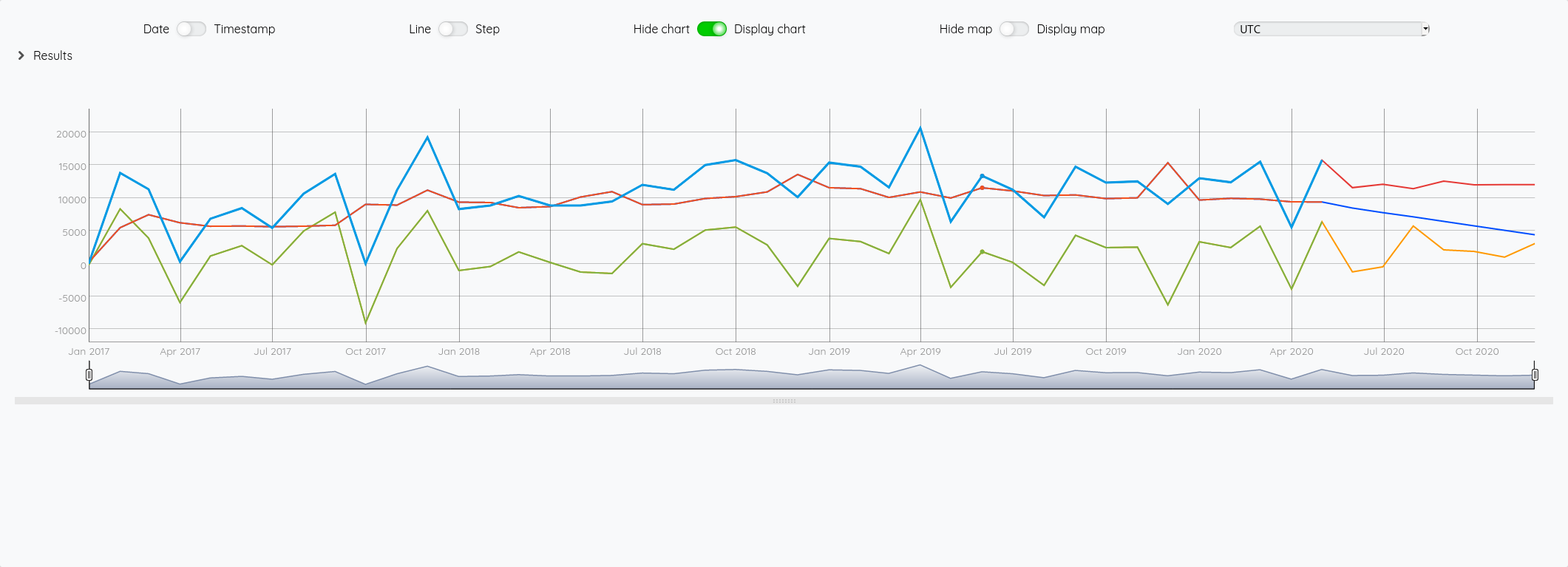

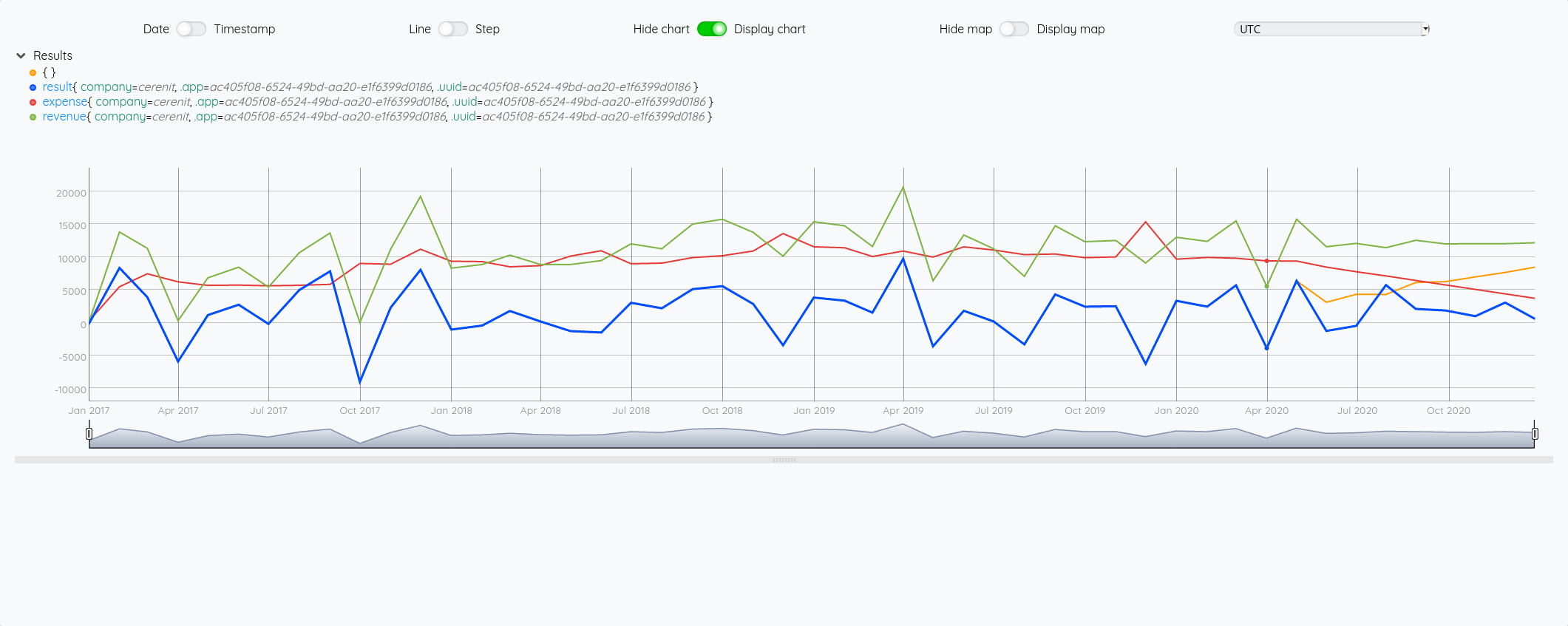

Du fait du FORECAST.ADDVALUES, on pourrait se passer d’afficher les trois premières séries. Mais vistuellement, cela permet de voir la différence entre la série originale et la projection.

Une fois l’effet Whaou passé, on peut se demander quel modèle a été appliqué. Pour cela il y a la fonction MODELINFO

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Récupération des trois séries

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

CLEAR

[ $result mapper.todouble 0 0 0 ] MAP

AUTO MODELINFO

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO MODELINFO

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO MODELINFO

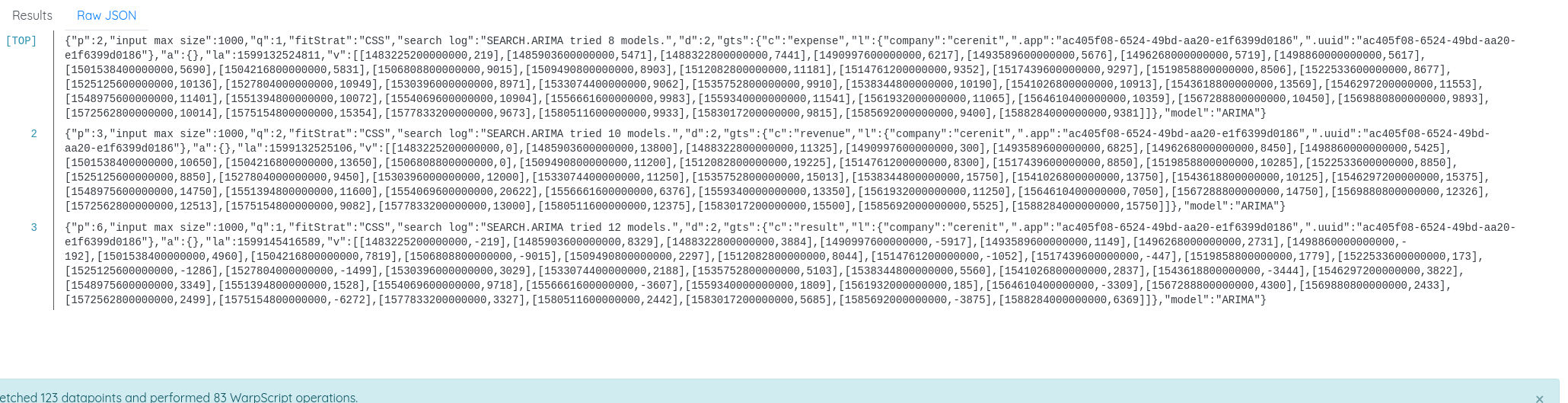

Dans l’onglet des résultats, on voit l’information: "model": "ARIMA".

Si on veut alors faire la même chose en utilisant le modèle ARIMA :

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Récupération des trois séries

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

CLEAR

# SEARCH.ARIMA: applique un modèle ARIMA (ARMA ou ARIMA) sur la GTS passée en paramètre

# FORECAST.ADDVALUES: fait une précision sur les 7 prochaines occurences et les fusionne avec la série sur laquelle la projection est faite.

# Les 3 projections restant dans la pile, elles sont affichées

[ $revenue mapper.todouble 0 0 0 ] MAP

SEARCH.ARIMA

7 FORECAST.ADDVALUES

[ $exp mapper.todouble 0 0 0 ] MAP

SEARCH.ARIMA

7 FORECAST.ADDVALUES

[ $result mapper.todouble 0 0 0 ] MAP

SEARCH.ARIMA

7 FORECAST.ADDVALUES

Et nous obtenons bien le même résultat.

On peut se poser alors la question de voir si la projection sur le résultat est la même que la soustraction entre la projection de chiffres d’affaires et de dépenses et mesurer l’éventuel écart.

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

[[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

CLEAR

# La différence sur les 3 projections est que l'on stocke chaque résultat dans une variable

[ $result mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

'fresult' STORE

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

'frevenue' STORE

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

'fexp' STORE

$frevenue

$fexp

$fresult

# ici on calcule la projection du résultat sur la base des projections de chiffres d'affaires et de dépenses

$frevenue $fexp -

On constate bien un écart entre la courbe orange (la soustraction des projections) et la courbe bleu (la projection du résultat).

Nous voilà à la fin de ce billet, j’espère que ce tour du propriétaire vous aura permis d’apprécier Warp10 et ses capacités.

Il ne reste plus qu’à voir en fin d’année dans quelles mesures ces projections seront valides ou pas !

Mon bilan sur Warp10 à ce stade :

- Il faut absolument suivre le tutoriel sur les cyclones, cela permet de se mettre progressivement à Warpscript et de comprendre les mécanismes de fonctionnement du langage et de la pile (stack).

- la notation de Warpscript est particulière au début mais on s’y fait petit à petit et sinon FLoWS devrait lever les dernières réticences.

- Comme on a une pile, il ne faut pas hésiter à utiliser

STOPetTYPOEOFnotamment pour savoir ce que l’on manipule comme donnée à un instant T ; cf Debugging WarpScript - Le WarpStudio ou l’extension VSCode permettent d’avoir un contexte de développement agréable avec l’autocomplétion, la documentation des fonctions, etc.

- Contrairement à InfluxDB où tout s’articule autour du measurement (équivalent de la classe ici), le fait d’avoir un langage de manipulation (et pas principalement de requêtage avec quelques transformations) de données permet d’avoir une modélisation plus souple et de réconcilier les données ensuite. Le même exercice dans InfluxDB supposerait d’avoir un seul measurement et d’avoir les différentes valeurs en son sein. Du coup, cela empêcherait le calcul et le stockage du résultat par ex. Il aurait fallu le calculer au préalable et l’insérer dans la base en même temps que les données de chiffre d’affaires et de dépenses pour que les données soient ensemble. Certes Flux et InfluxDB 2.0 vont lever quelques contraintes de modélisation et de manipulation de données, mais le prisme de la modélisation autour du measurement reste primordial dans le produit.

- Avoir un langage de manipulation de données et non uniquement de requêtage et quelques transformation évite aussi de devoir sortir les données pour les analyser puis les renvoyer vers la base de données le cas échéant. Non seulement on reste au plus près de la donnée (éxécution coté serveur) mais on évite aussi les problématiques de drivers, conversion dans les structures de données du langage cible, etc.

- Les classes de warpscript sont certes mono valeurs (même si le multivalue existe) mais je présume que cela sert surtout pour des données de même nature plutôt que pour des données hétérogènes. En effet, il s’agit d’une liste et non d’un tableau de données. (NDLR: Mathias me précise qu’une multivalue est une GTS et non une simple liste - cela est précisé si on lit bien la totalité de la doc de multivalue)

Une expérience au final positive qui pousse à aller creuser plus loin les fonctionnalités de cette plateforme. Ce sera l’opportunité de rédiger d’autres billets à l’avenir.

Web, Ops & Data - Juillet 2020

terraform acme letsencrypt influxdb influxdays questdb timeseries rancher suse stash kubedb maesh warp10 warpscript flows ptsm rgpd safe-harbor données personnelles grafana fluxCloud

- Gestion automatisée de certificats TLS avec Let’s Encrypt via Terraform et Ansible sur AWS : exemple d’utilisation du provider

acmeavec terraform pour la génération et le déploiement d’un certificat Let’s Encrypt dans un contexte AWS. - Custom Variable Validation in Terraform 0.13 : introduite en version expérimentale en 0.12.20, la validation personnalisée de variable sera stable en v ersion 0.13. De quoi valider ses ressources plus simplement.

- Avec l’acquisition d’OpenIO, OVHcloud se donne pour ambition de créer la meilleure offre de Stockage Objet du marché : acquisition d’OpenIO par OVHCloud. OpenIO fournit une solution de stockage compatible S3 et apparemment OVHVloud et OpenIO étaient habituées à travailler ensemble notamment autour de Swift (le stockage objet dans Openstack). Intéressant de voir ce type d’acquisition en Europe d’une part et de voir qu’OVHCloud remonte dans la chaine de valeur et rentre de plus en plus dans le monde du logiciel. A suivre !

Container et orchestration

- Announcing Maesh 1.3 : Maesh continue son chemin et ajoute la capacité de surveiller des namespace particuliées (en plus de pouvoir en ignorer), le support du lookup des ports (http -> 80), le support de CoreDNS chez AKS et d’autres améliorations encore.

- Electro Mpnkeys #9 – Traefik et Maesh : de l’ingress au service mesh avec Michael Matur : si vous voulez en savoir plus sur Traefik et Maesh, je vous conseille cet épisode (et les autres) du podcast Electro Monkeys.

- Introducing Traefik Pilot: a First Look at Our New SaaS Control Platform for Traefik : Containous, la société derrière Traefik, Maesh et Yaegi sort son offre SaaS pour piloter et monitorer ses instances traefik. Un système de plugins pour les middleware fait également son apparaition. Il faut une version 2.3+ (actuellement en RC) de Traefik pour bénéficier de cette intégration.

- Relicensing Stash & KubeDB : KubeDB, l’operateur de bases de données et Stash, l’outil de sauvegarde se cherchent un modèle économique et changent de licence. La version gratuite, avec code source disponible, reste disponible pour des usages non commerciaux (voir les détails de la licence pour une slite exacte). Pour un usage commercial, il faudra passer par la version Entreprise qui apporte aussi des fonctionnalités supplémentaires.

- Suse to acquire Rancher : Suse était sorti de mon radar; c’est donc pour moi l’entrée (ou le retour ?) de Suse dans le monde de kubernetes et de son orchestration. Est-ce une volonté d’aller prendre des parts de marchés à Redhat/Openshift ou de faire face à des rumeurs telles que Google en discussion pour acquérir D2IQ (ex Mesoshphère) ? A voir si cette acquisition va être un tremplin pour Rancher et ses différents projets (rke, rio, k3s, longhorn, etc) comme l’indique son CTO ou pas.

Time Series

- QuestDB nabs $2.3M seed to build open source time series database : QuestDB, historiquement issue du monde du trading à haute fréquence, commence à faire parler d’elle (notamment en récupérant un des DevRel d’InfuxData David G Simmons et vient de lever 2.3 millions de dollars. Elle a une approche SQL sur le traitement des données, se veut performante. A voir si elle reste une spécialiste de la série temporelle financière ou si elle parvient à s’ouvrir à d’autres usages.

- InfluxDays 2020 Virtual Experience : les vidéos et supports des InfluxDays sont disponibles.

- Paris Time Series Meetup #5 : De retour des InfluxDays et FLoWS : Résumé des keynotes autour des annonces produits des InfluxDays et présentation de FLoWS, la nouvelle syntaxte proposée par SenX pour interagir avec Warp10, en alternative à WarpScript. Le but est de faciliter la courbe d’apprentissage autour de Warp10. FLoWS est déjà disponible sur la sandbox et sera disponible cet été ou à la rentrée dans la version 2.7.0 de Warp10.

- Grafana v7.1 released: New features for InfluxDB and Elasticsearch data sources, table panel transformations, and more : grosse nouvelle version mineure de Grafana avec son lots d’amélioration et de nouveautés. Je vous laisse lire l’annonce.

- How to Build Grafana Dashboards with InfluxDB, Flux and InfluxQL : A l’occasion de la sortie de Grafana 7.1 qui apporte le support de Flux, présentation des nouveaux modes d’interaction entre Grafana et InfluxDB

Vie privée & données personnelles

Le Privacy Shield, l’accord entre l’Europe et les USA sur le transfert des données des Européens vers les USA (ou les sociétés américaines) vient d’être invalidé par la cour de justice européene. Les flux “absolument nécessaires” peuvent continuer à se faire pour le moment et la cour a validé “les clauses contractuelles types” définies par la Commission Européenne pourront être utilisées par les entreprises. Néanmoins, pour s’y référer, il semble qu’il faut vérifier que l’entreprise protège effectivement les données. Je vous invite à contacter votre juriste ou avocat pour mieux appréhender les impacts de cette invalidation si vous utilisez les plateformes cloud et des services dont les entreprises sont basées aux USA. En tant qu’individu, il peut être intéressant de se poser des questions également. N’étant pas juriste, je vais donc limiter mon interprétation ici et vous laisse lire les liens ci-dessous.

- La justice européenne sabre le transfert de vos données vers les USA à cause de la surveillance de masse

- L’accord sur le transfert de données personnelles entre l’UE et les Etats-Unis annulé par la justice européenne

- CJEU Judgment - First Statement

- L’accord sur le transfert de données personnelles avec les États-Unis invalidé par la justice européenne

- Invalidation du « Privacy shield » : la CNIL et ses homologues analysent actuellement ses conséquences

- Statement on the Court of Justice of the European Union Judgment in Case C-311/18 - Data Protection Commissioner v Facebook Ireland and Maximillian Schrems

- The End of the Privacy Shield Agreement Could Lead to Disaster for Hyperscale Cloud Providers

Web, Ops & Data - Mars 2020

ansible molecule test java redis timeseries influxdb warp10IaC

- Ansible Molecule 3.0 : l’outil de test des rôles Ansible est passé en version 3.0. Pas mal de changement avec l’externalisation des providers d’infrastructure sous la forme de module python et d’autres rationalisation. Une check list de migration est disponible

Langages

- What Tens of Millions of VMs Reveal about the State of Java : NewRelic publie une synthèse des versions et configuration de Java déployées dans la nature. ~85% tourne encore sur Java 8 et 11% sur Java 11 et le tout principalement avec les versions fournies par Oracle. On se moquait des communautés PHP (pour PHP 5 à PHP 7) ou Python (2 vers 3) mais visiblement chaque langage d’un certain age rencontre les mêmes soucis.

Time Series

- RedisTimeSeries Version 1.2 Is Here! : ce module qui apporte des fonctionnalités de séries temporelles à Redis (sans pour autant en faire une base de données orientée séries temporelles) passe en 1.2. On y trouve surtout des améliorations au niveau de la compression des données, des améliorations de performance et une rationnalisation de l’API.

- SenX publie un guide indiquant les propriétés d’une base de donnée timeseries et comment Warp10 se positionne sur les différents axes. Un joli travaille pédagogique.

- Warp10 a dépassé les 1000 fonctions

- InfluxDB 2.0 - beta 6 : améliorations de l’ensemble et l’apparition des premières fonctions géospatiales dans Flux.

- Le site du Paris Time Series Meetup est en ligne ; à défaut de meetup, vous pourrez y retrouver les vidéos et supports des précédentes éditions.

Bilan 2019 et perspectives 2020

bilan perspective cérénit timeseries bigdatahebdo influxaceRien de tel que la finalisation du bilan de cette troisième année d’activité pour faire un petit bilan sur l’année écoulée et les perspectives pour 2020. Vous pouvez retrouver le bilan des années précédentes 2018 et 2017.

Bilan 2019

Au global, tout va toujours bien, tant d’un point de vue comptable que d’activité. Une année plutôt bien remplie, voir trop remplie en nombre de jours facturés. Cela change des années précédentes où cela avait pu être un problème.

D’un point de vue comptable, cela donne :

| 2019 | 2018 | 2017 | Variation n/n-1 | |

|---|---|---|---|---|

| Chiffre d’affaires | ~150 K€ | ~132 K€ | ~100 K€ | +14% |

| Résultat après impôts | ~13.5 K€ | ~10 K€ | ~20 K€ | +31% |

| Jours facturés | ~210 | ~190 | ~160 | +10% |

| TJM | ~714€ | ~685€ | 625€ | +4% |

J’avais espéré retrouvé mon delta de chiffre d’affaires de façon plus sensible dans mon résultat. Ce n’est pas le cas principalement pour les raisons suivantes :

- Le choix de meilleures mutuelle et système de prévoyance, ainsi que la mise en place d’un financement de retraites complémentaires au niveau de l’entreprise,

- Des investissements matériels du fait d’un travail en remote à mon domicile depuis le mois de juillet et pour le Meetup Paris Time Series,

- Des dépenses pour la réalisation d’une nouvelle identité graphique pour CérénIT, BigData Hebo et pour le Meetup Paris Time Series.

Comme chaque année, j’en profite pour remercier Fabrice et son équipe pour son accompagnement. Je l’ai déjà dit, mais avoir confiance dans son expert comptable et pouvoir compter sur lui pour apporter de bons conseils aux bons moments et être serein sur la gestion de l’entreprise, c’est indispensable.

D’un point de vue activité, c’est aussi une bonne année :

- Contraitement aux années précédentes, avoir des missions plus régulières m’a permis de ne pas avoir le déséquilibre entre le premier et le second semestre,

- Fin d’une mission de 18 mois au final chez LesFurets.com et depuis 6 mois, une mission en cours chez Saagie ; les détails de ces missions sont disponibles sur la page Références.

- L’investissement sur Kubernetes depuis courant 2018 m’a permis de décrocher plusieurs missions et ainsi d’avoir des références “officielles” en la matière.

- J’avais fait le choix d’aller à moins de conférences mais je me suis rendu à KubeCon Europe à Barcelone, aux InfluxDays à Londres et au Sysadmin_Days à Paris,

- J’ai eu le plaisir de rejoindre l’équipe du podcast BigData Hebo et d’être nominé InfluxAces. Nomination qui m’a permis de lancer et d’animer le Meetup Paris Time Series depuis le mois de septembre,

- J’ai pu rejoindre le réseau d’indépendants CollectiveMakers qui permet de partager de l’information et d’avoir un réseau d’entraide sur des problématiques Ops/Cloud/DevOps/Sécurité.

- Enfin, j’ai même pu me verser mes premiers dividendes, preuve de la bonne santé de l’entreprise.

Perspectives 2020

Avec la nomination d’InfluxAces, le travail sur le Meetup Paris Time Series et une première mission sur les séries temporelles, l’objectif 2020 est de développer cette activité. Je compte donc passer une partie de l’année à améliorer ma maitrise de la plateforme InfluxDB 2.0 mais aussi de la plateforme Warp10. Pour se faire, je suis passé à 4/5ème sur ma mission actuelle pour avoir un temps dédié à ce sujet et quelques autres projets à finir.

Outre cette activité, j’ai aussi prévu d’améliorer/renforcer mes compétences en matière de développement. Je m’étais rapidement formé à Go en vue d’une mission qui s’est finalement faite en Kotlin. Je compte donc creuser un peu plus le monde de la JVM (Java, Gradle, Kotlin) pour mieux comprendre son fonctionnement mais aussi voir du coté de Rust qui m’a plus séduit que Go. Avoir raté une belle opportunité de projet du fait de ne pas être assez développeur me pousse à vouloir investir sur ce sujet en plus du plaisir que j’ai à développer.

Sur les conférences, j’ai prévu d’aller à Devoxx France et à la prochaine édition des InfluxDays. A voir pour le reste de l’année.

Après un premier chantier de refonte du site suite à la nouvelle identité, je dois encore le faire évoluer pour mieux présenter les offres de service ainsi que d’autres améliorations.

Enfin, comme tous les ans, j’ai prévu de travailler à la pérénité et soutenabilité de CérénIT, d’apprendre plein de nouvelles choses pour rester pertinent et aller de l’avant. A celà s’ajoute le plaisir de contribuer/participer à la communauté BigData Hebo.

Si certains sujets vous interpellent ou si vous avez des contacts à me suggérer, n’hésitez pas à me contacter.