Architecte de vos plateformes/produits et agitateur de séries temporelles

Conception, développement, déploiement et exploitation de vos plateformes, applications et données.

Contactez-nous !Ma comptabilité, une série temporelle comme les autres - partie 2 - actualisation des données et des prévisions

warp10 timeseries comptabilité prévision forecastSuite de notre épopée :

- Partie 1 - Premier pas avec Warp 10, comptabilité et prévisions de fin d’année

- Partie 2 - Remise à jour des données, comparaison des données prévues vs réelles, prévisions 2021 (ce billet)

- Partie 3 - Récupération des données de la Sandbox dans notre instance locale

- Partie 4 - Dashboards

- Partie 5 - Les FEC et le compte 512

- Partie 6 - Les FEC et le compte de résultat

L’année dernière, nous avions travaillé sur Warp 10 et mes données de comptabilité et jouer un peu avec les algo de prévision.

Les données comptables ayant été un peu ajustées entre temps et la librairie de prévision ayant aussi évolué coté SenX, les résultats ne sont plus tout à fait les mêmes. Nous allons donc reprendre tout ça.

Rappel des fais et prévisions à fin 2020

En septembre dernier, nous avions ce code pour avoir les données jusqu’au mois de Mai 2020 et une prévision jusqu’à la fin d’année:

'<read token>' 'readToken' STORE

'<write token>' 'writeToken' STORE

// Récupération des données de dépenses / chiffre d'affaires / résult pour la période du 01/01/2017 -> 31/05/2020

// Chaque série est stockée dans une variable

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

// On affiche les trois courbes

$revenue

$exp

$result

// On génère et affiche les prévisions - on renomme les séries pour mieux les différencier ensuite au niveau dataviz

[ $result mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"forecast_result" RENAME

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"forecast_revenue" RENAME

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"forecast_expense" RENAME

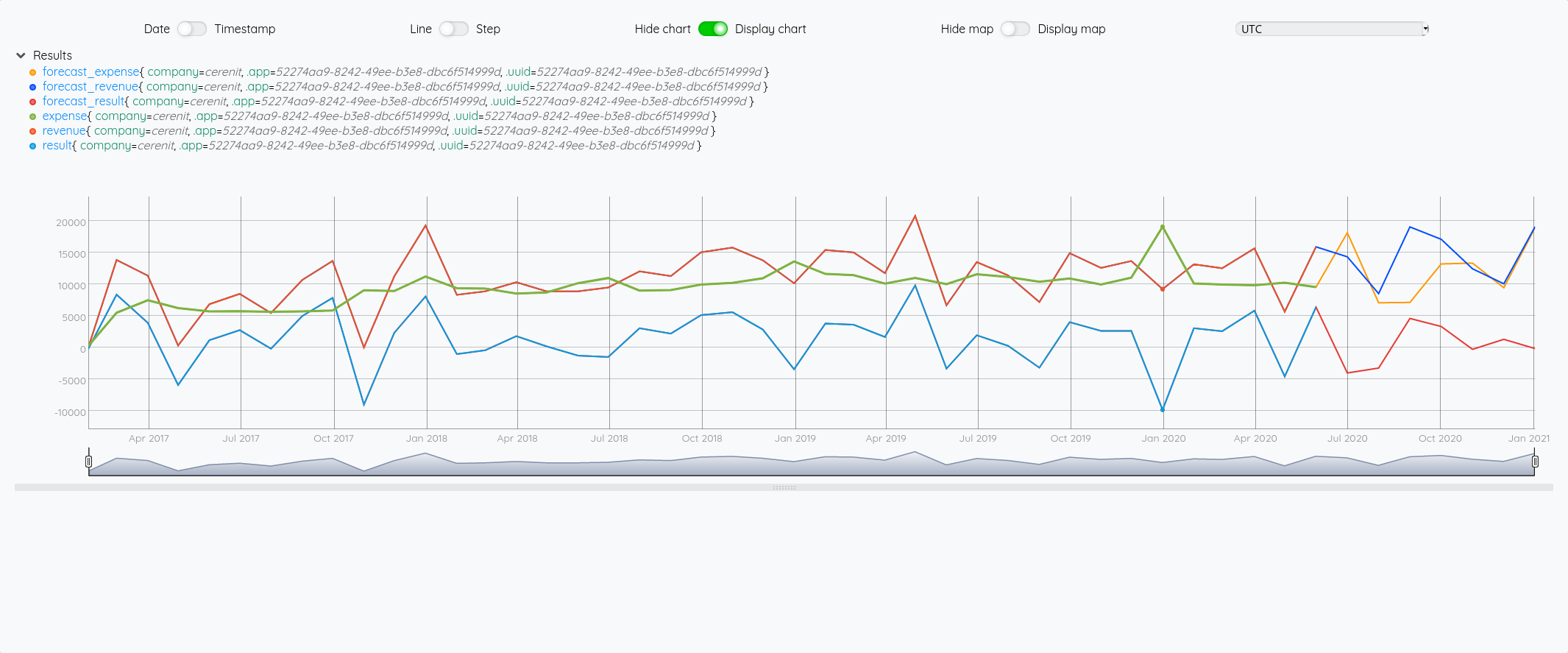

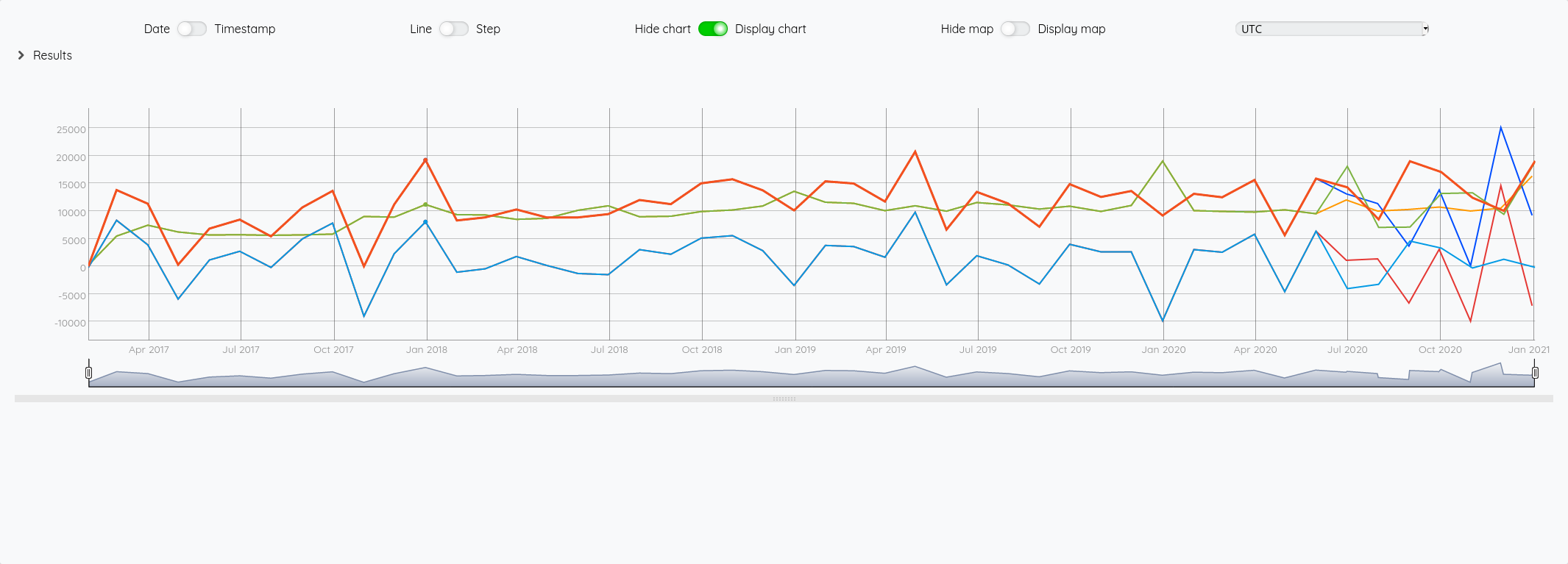

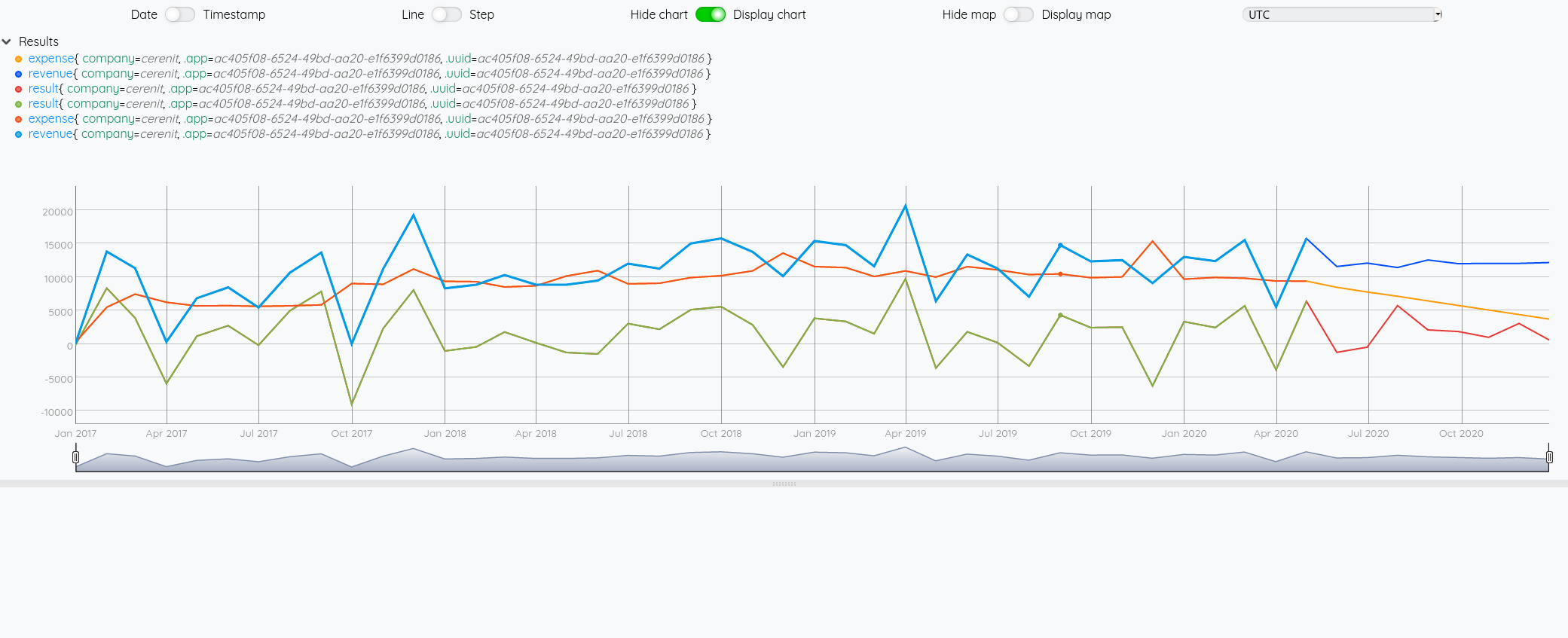

Au global :

Focus 2020 avec la partie prévision à partir de juin :

Si on fait la même chose en prenant un algo incluant un effet de saisonnalité :

'<read token>' 'readToken' STORE

'<write token>' 'writeToken' STORE

// Récupération des données de dépenses / chiffre d'affaires / résult pour la période du 01/01/2017 -> 31/05/2020

// Chaque série est stockée dans une variable

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

// On affiche les trois courbes

$revenue

$exp

$result

[ $result mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"forecast_result" RENAME

[ $revenue mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"forecast_revenue" RENAME

[ $exp mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"forecast_expense" RENAME

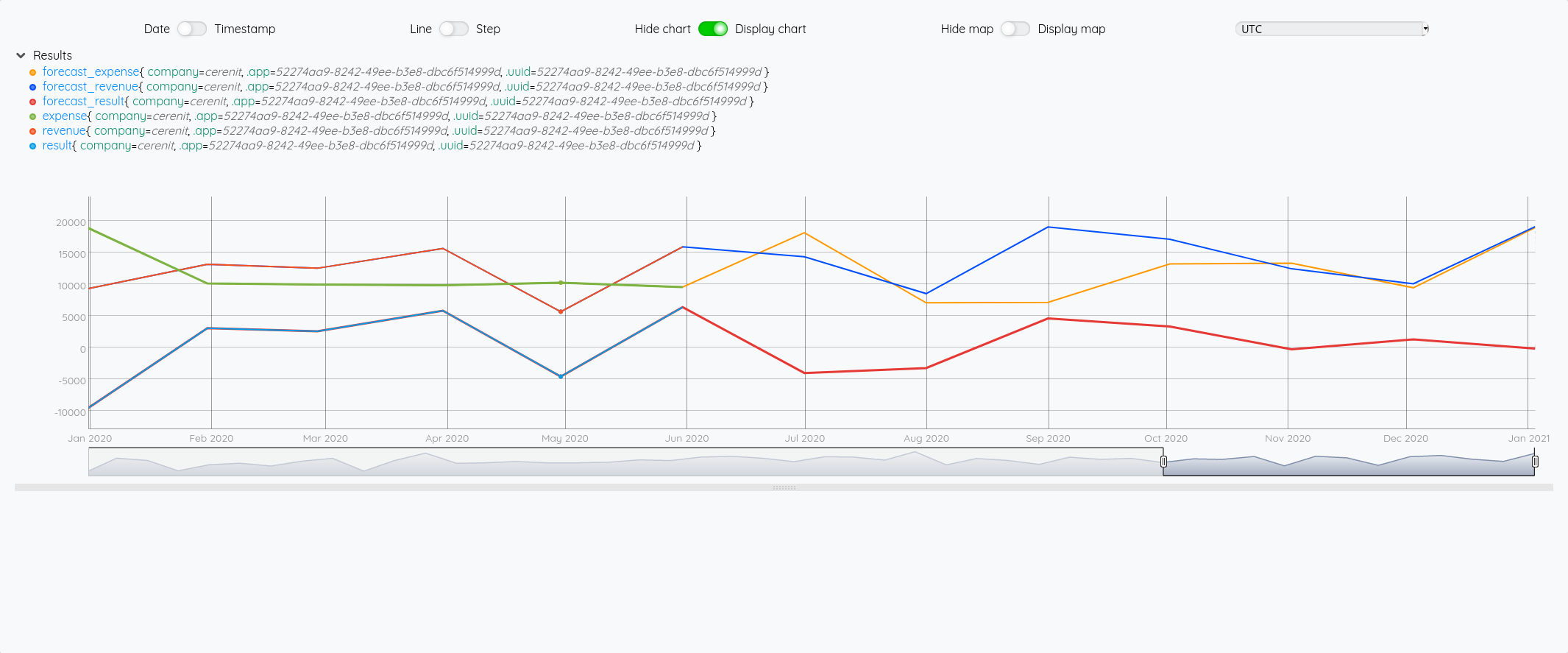

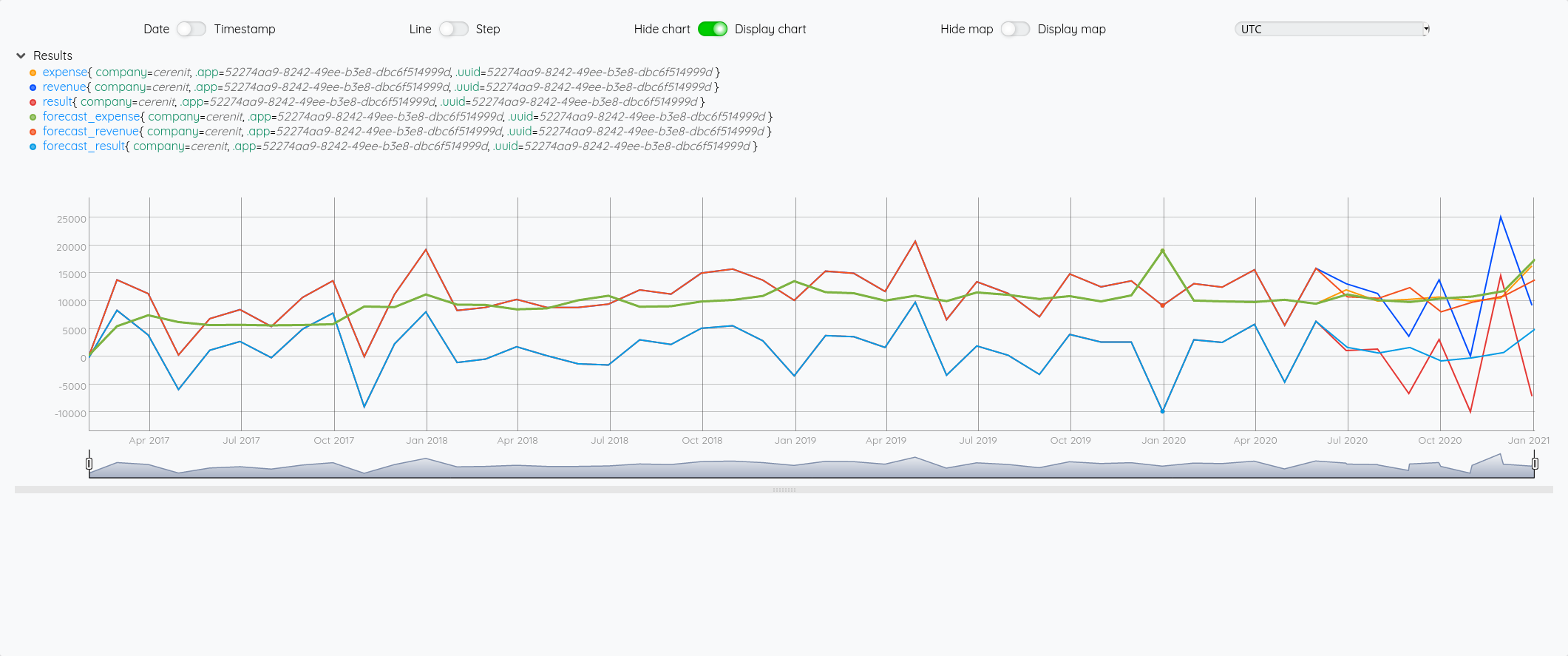

Au global :

Focus 2020 avec la partie prévision à partir de juin :

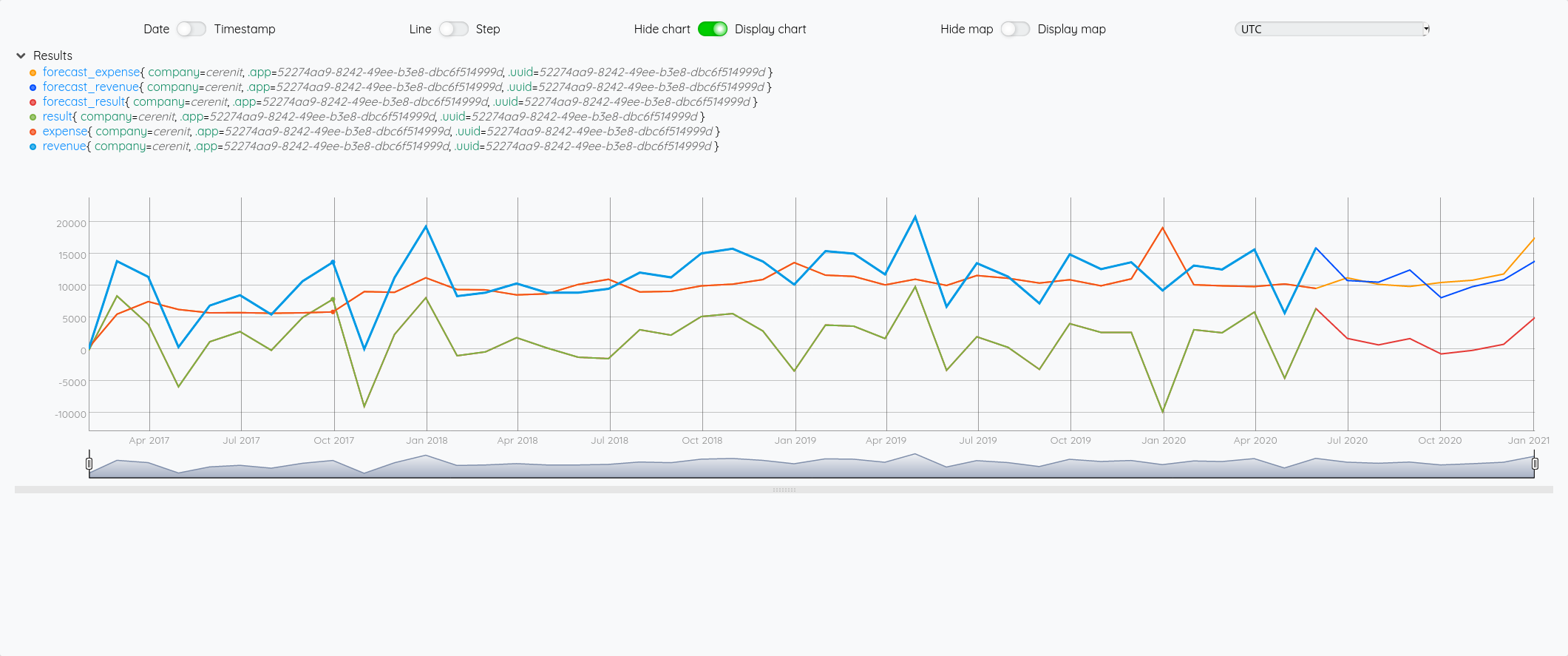

On a bien un petit écart de comportement sur la prévision entre les deux modèles (focus sur 2020 avec les différentes prévisions à partir de juin) :

'<read token>' 'readToken' STORE

'<write token>' 'writeToken' STORE

// Récupération des données de dépenses / chiffre d'affaires / résult pour la période du 01/01/2017 -> 31/05/2020

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

[ $result mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"sauto_result" RENAME

[ $revenue mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"sauto_revenue" RENAME

[ $exp mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"sauto_expense" RENAME

// On génère et affiche les prévisions - on renomme les séries pour mieux les différencier ensuite au niveau dataviz

[ $result mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"auto_result" RENAME

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"auto_revenue" RENAME

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"auto_expense" RENAME

Prévisions vs réalité

Comparons maintenant les prévisions à la réalité - je vais rajouter les requêtes pour avoir la vue complète des données - pour éviter de trop surcharger le graphique, comme les séries forecast_* reprennent les données sources et y ajoutent la prévision, je ne vais afficher que ces séries et les séries réelles :

'<read token>' 'readToken' STORE

'<write token>' 'writeToken' STORE

// Récupération des données de base qui serviront ensuite pour la prévision

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

// Récupération des données réelles de la période 01/01/2017 > 31/12/2020

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'real_exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'real_revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'real_result' STORE

// Génération des prévisions

// Pour SAUTO, il faut définir en plus un cycle, ici 12 mois

[ $result mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"forecast_result" RENAME

[ $revenue mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"forecast_revenue" RENAME

[ $exp mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"forecast_expense" RENAME

$real_result

$real_revenue

$real_exp

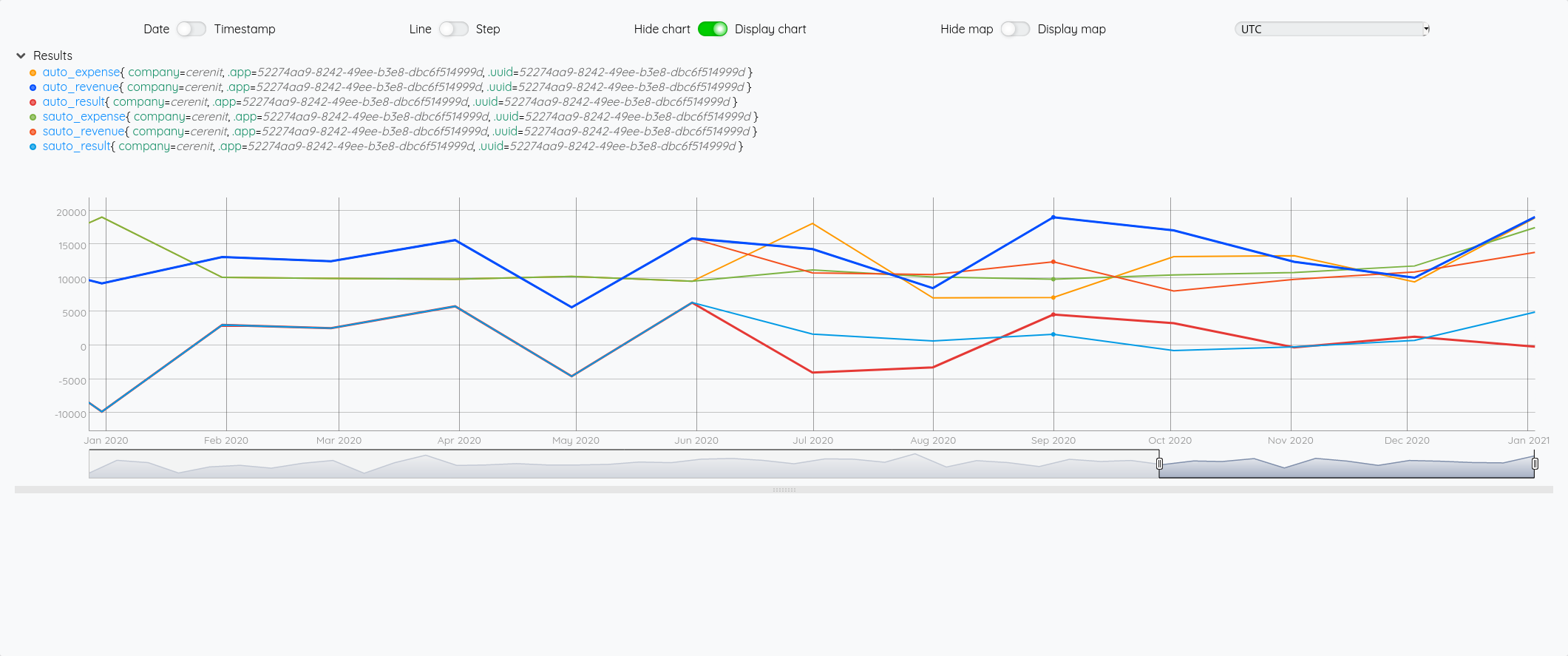

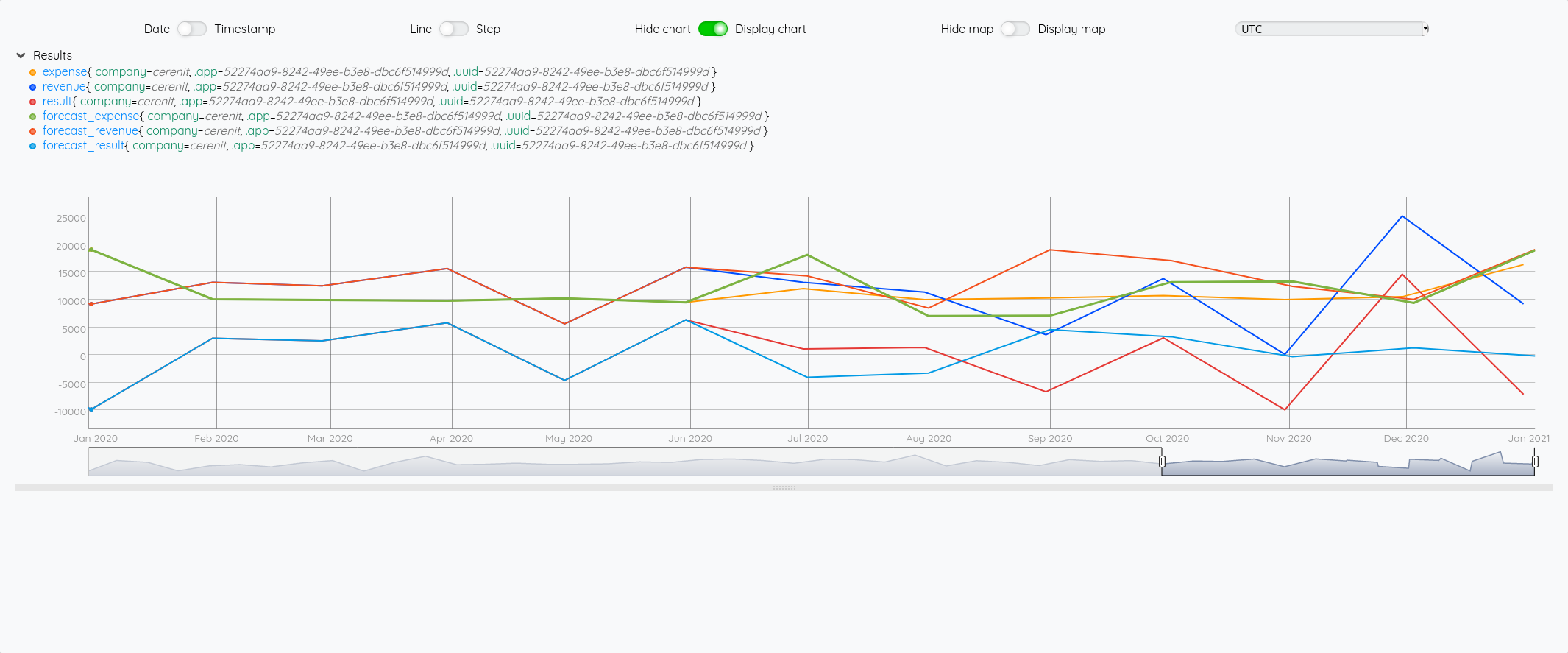

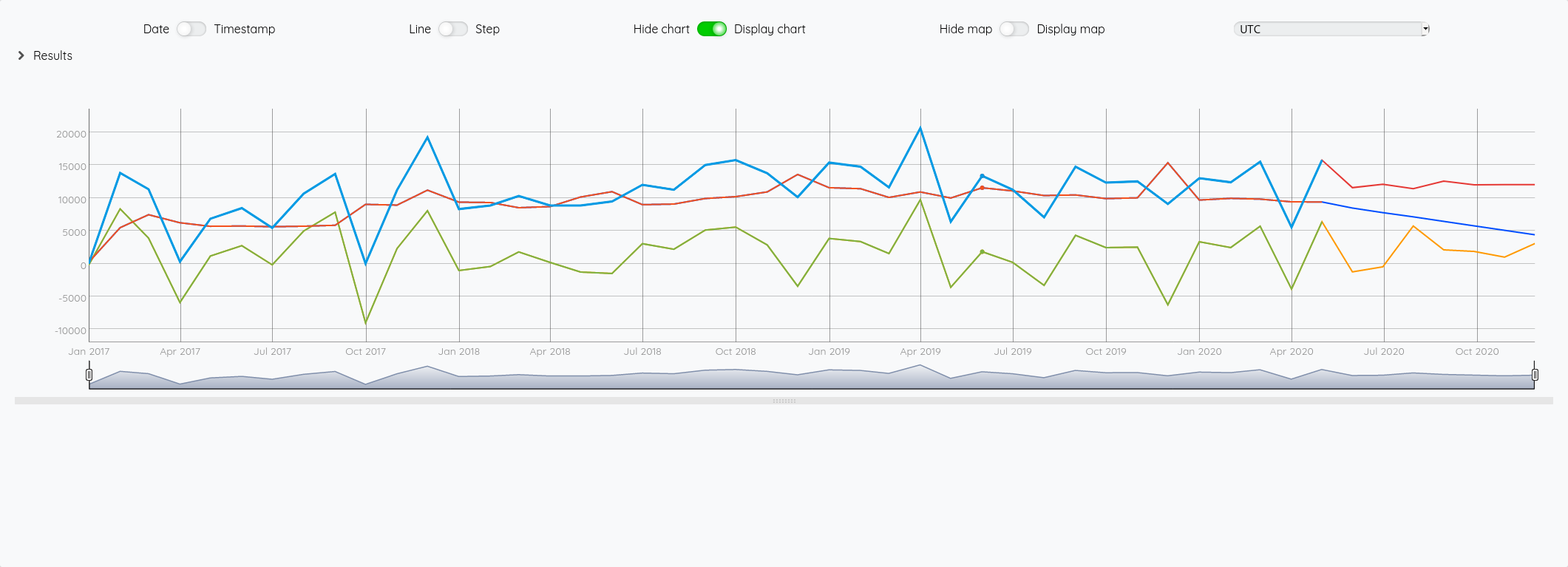

Ce qui nous donne au global :

et avec le focus 2020 :

Si on fait la même chose avec SAUTO

'<read token>' 'readToken' STORE

'<write token>' 'writeToken' STORE

// Récupération des données de base qui serviront ensuite pour la prévision

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

// Récupération des données réelles de la période 01/01/2017 > 31/12/2020

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'real_exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'real_revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'real_result' STORE

// Génération des prévisions

[ $result mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"forecast_result" RENAME

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"forecast_revenue" RENAME

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"forecast_expense" RENAME

$real_result

$real_revenue

$real_exp

Au global :

Focus 2020 avec la partie prévision à partir de juin :

Essayons d’analyser tout ça (il faut regarder les fins de mois - les points sont en date du dernier jour du mois) :

- Pour Juin/Juillet, la prévision est plutôt bonne.

- Pour Aout : l’écart vient du fait que j’ai pris mes vacances en aout et pas à cheval sur juillet/aout comme les autres années

- Pour Septembre, c’est correct

- Pour Octobre, il faut voir que j’ai tardé à éditer mes factures - elles ont donc été pris en compte sur Novembre - si on divise le montant de Novembre en deux, on retombe à peu près sur nos points

- Pour décembre, un effet vacances également.

La pertinence est prévisions est donc plutôt correct au global et les écarts sont expliquables.

Consolidation annuelle

Et au niveau annuel ? Est-ce que les prévisions de chiffres d’affaires / dépenses / résultats sont bonnes si on ne tient plus compte des petits écarts de temps ci-dessus ?

Voyons celà :

'<read token>' 'readToken' STORE

'<write token>' 'writeToken' STORE

// Récupération des différentes séries comme précédemment

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'real_exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'real_revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'real_result' STORE

// Calcul des prévisions comme précédemment

// Petit ajout, on stocke le résultat sous la forme d'une variable pour être réutilisé ultérieurement

[ $result mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"auto_result" RENAME

'auto_result' STORE

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"auto_revenue" RENAME

'auto_revenue' STORE

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO 7 FORECAST.ADDVALUES

"auto_expense" RENAME

'auto_expense' STORE

// Aggrégation annuelle

// Utilisation de BUCKETIZE.CALENDAR et de la macro BUCKETIZE.byyear qui s'appuie dessus et qui permet de faire une aggrégation annuelle sur des données

// bucketizer.sum permet d'appliquer une somme sur les données regroupées par année

// UNBUCKETIZE.CALENDAR permet de retransformer l'indice issue de BUCKETIZE.CALENDAR en timestamp

[ $real_revenue bucketizer.sum ] @senx/cal/BUCKETIZE.byyear UNBUCKETIZE.CALENDAR

[ $real_result bucketizer.sum ] @senx/cal/BUCKETIZE.byyear UNBUCKETIZE.CALENDAR

[ $real_exp bucketizer.sum ] @senx/cal/BUCKETIZE.byyear UNBUCKETIZE.CALENDAR

[ $auto_revenue bucketizer.sum ] @senx/cal/BUCKETIZE.byyear UNBUCKETIZE.CALENDAR

[ $auto_result bucketizer.sum ] @senx/cal/BUCKETIZE.byyear UNBUCKETIZE.CALENDAR

[ $auto_expense bucketizer.sum ] @senx/cal/BUCKETIZE.byyear UNBUCKETIZE.CALENDAR

// Meme chose pour SAUTO

[ $result mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"sauto_result" RENAME

'sauto_result' STORE

[ $revenue mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"sauto_revenue" RENAME

'sauto_revenue' STORE

[ $exp mapper.todouble 0 0 0 ] MAP

12 SAUTO 7 FORECAST.ADDVALUES

"sauto_expense" RENAME

'sauto_expense' STORE

[ $sauto_revenue bucketizer.sum ] @senx/cal/BUCKETIZE.byyear UNBUCKETIZE.CALENDAR

[ $sauto_result bucketizer.sum ] @senx/cal/BUCKETIZE.byyear UNBUCKETIZE.CALENDAR

[ $sauto_expense bucketizer.sum ] @senx/cal/BUCKETIZE.byyear UNBUCKETIZE.CALENDAR

Pour expliciter un peu au dessus :

On veut obtenir un résultat annuel couvant la période du 01/01 au 31/12 d’une année. Il faut donc prendre tous les points de l’année en question et en fait la somme.

Si on fait:

[ $real_revenue bucketizer.sum ] @senx/cal/BUCKETIZE.byyear

On obtient :

[{"c":"revenue","l":{"company":"cerenit",".app":"52274aa9-8242-49ee-b3e8-dbc6f514999d",".uuid":"52274aa9-8242-49ee-b3e8-dbc6f514999d"},"a":{".buckettimezone":"UTC",".bucketduration":"P1Y",".bucketoffset":"0"},"la":1612528364518,"v":[[47,100850],[48,132473],[49,151714],[50,139146]]}]

Les valeus obtenues sont :

[[47,100850],[48,132473],[49,151714],[50,139146]]

Les indices 47, 48, 49, 50 sont en fait un delta par rapport au 01/01/70. En effet, 2020 = 1970 + 50

En appliquant UNBUCKETIZE.CALENDAR, on retransforme ce 50 par ex en son équivalent sous la forme d’un timestamp : 1609459199999999.

On peut aussi utiliser TIMESHIFT de la façon suivante :

[ $real_revenue bucketizer.sum ] @senx/cal/BUCKETIZE.byyear 1970 TIMESHIFT

Pour obtenir pour la partie valeur :

[[2017,100850],[2018,132473],[2019,151714],[2020,139146]]

Pour en savoir plus sur BUCKETIZE.CALENDAR et ses utilisations : Aggregate by calendar duration in WarpScript

Une fois qu’on reprend toutes ses données, on peut essayer de mesurer les écarts entre le réél et les prévisions des deux modèles :

| AUTO | SAUTO | Réel | AUTO vs Réel | SAUTO vs Réel | |

|---|---|---|---|---|---|

| Chiffre d’affaires | 144.029 | 125.128 | 139.146 | -3,39% | +11,20% |

| Dépénses | 117.701 | 113.765 | 129.464 | +9,99% | +13,80% |

| Résultat | 14.754 | 16.893 | 9.682 | -34,38% | -42,69% |

| Résultat corrigé | 26.328 | 11.363 | 9.682 | -63,23% | -14,79% |

Intéressant, la prévision de résultat n’est pas égale à la différence entre la prévision de chiffre d’affaires et la prévision des dépenses ! C’est la raison de la ligne “Résultat corrigé”.

A ce stade, il ne me semble pas possible de privilégier un modèle plus qu’un autre - même si du fait de la récurrence des vacances, on peut supposer que le modèle avec saisonnalité pourrait être plus pertinent.

Prévisions pour 2021

Pour aller au bout de cet exerice, il ne reste plus qu’à voir ce que nos algoritmes prévoient pour 2021 :

'<read token>' 'readToken' STORE

'<write token>' 'writeToken' STORE

// Récupération des séries 2017 > 2020

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2021-01-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

// Prévision sur les 12 prochains mois

[ $result mapper.todouble 0 0 0 ] MAP

AUTO 12 FORECAST.ADDVALUES

"auto_result" RENAME

'auto_result' STORE

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO 12 FORECAST.ADDVALUES

"auto_revenue" RENAME

'auto_revenue' STORE

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO 12 FORECAST.ADDVALUES

"auto_expense" RENAME

'auto_expense' STORE

// Consolidation annuelle avec AUTO

[ $auto_revenue bucketizer.sum ] @senx/cal/BUCKETIZE.byyear 1970 TIMESHIFT

[ $auto_result bucketizer.sum ] @senx/cal/BUCKETIZE.byyear 1970 TIMESHIFT

[ $auto_expense bucketizer.sum ] @senx/cal/BUCKETIZE.byyear 1970 TIMESHIFT

// Prévisions avec SAUTO

[ $result mapper.todouble 0 0 0 ] MAP

12 SAUTO 12 FORECAST.ADDVALUES

"sauto_result" RENAME

'sauto_result' STORE

[ $revenue mapper.todouble 0 0 0 ] MAP

12 SAUTO 12 FORECAST.ADDVALUES

"sauto_revenue" RENAME

'sauto_revenue' STORE

[ $exp mapper.todouble 0 0 0 ] MAP

12 SAUTO 12 FORECAST.ADDVALUES

"sauto_expense" RENAME

'sauto_expense' STORE

// Consolidation annuelle avec SAUTO

[ $sauto_revenue bucketizer.sum ] @senx/cal/BUCKETIZE.byyear 1970 TIMESHIFT

[ $sauto_result bucketizer.sum ] @senx/cal/BUCKETIZE.byyear 1970 TIMESHIFT

[ $sauto_expense bucketizer.sum ] @senx/cal/BUCKETIZE.byyear 1970 TIMESHIFT

On passe tout ça dans le shaker et on obtient :

| Prévu avec AUTO | Prévu avec SAUTO | |

|---|---|---|

| Chiffre d’affaires | 78.230 | 129.465 |

| Dépénses | 118.383 | 110.434 |

| Résultat prévu | 5.730 | 4.049 |

| Résultat corrigé | -40.153 | 19.031 |

Rendez-vous à la fin de l’année pour voir ce qu’il en est… et on peut espérer que la réalité sera proche du modèle avec saisonnalité !

Pour le moment, on travalle toujours dans le WarpStudio et on voudrait bien avoir des (jolis) dashboards qui font tout ça pour nous plutôt que de copier/coller du Warpscript. Ce sera le sujet de la partie 3.

Premiers pas avec Warp 10 : comptabilité et prévisions de fin d'année

warp10 timeseries forecast dashboard warpstudio arimaSuite de notre épopée :

- Partie 1 - Premier pas avec Warp 10, comptabilité et prévisions de fin d’année (ce billet)

- Partie 2 - Remise à jour des données, comparaison des données prévues vs réelles, prévisions 2021

- Partie 3 - Récupération des données de la Sandbox dans notre instance locale

- Partie 4 - Dashboards

- Partie 5 - Les FEC et le compte 512

- Partie 6 - Les FEC et le compte de résultat

Cherchant à me familiariser avec la base de données orientée série temporelles Warp 10 d’une part et à améliorer mes tableaux de bord comptables pour me faire des projections à fin d’année (parce que bon, faire juste la moyenne des mois précédents comme valeur pour les mois à venir, c’est un peu trop facile), je me suis dit que c’était un exercice qui pouvait répondre aux deux besoins après avoir lu Time series forecasts in WarpScript.

Pour ceux qui ne connaissent pas encore Warp 10 , c’est une solution de geo-timeseries (séries spatio temporelles) open source, éditée par SenX, société française basée à Brest. Pour en savoir plus sur Warp 10 , vous pouvez regarder l’éditions 1 et l’édition 5 du Paris Time Series Meetup.

Pour prendre en main Warp 10 et appréhender le langage de programmation Warpscript, je vous invite à suivre le tutoriel sur les cyclones en utilisant la Sandbox Warp10 mise à disposition par Senx.

Le jeu de données

Pour le jeu de données, j’ai donc récupéré de mes tableaux de bords mon chiffre d’affaires et mes dépenses mensuels sur la période Janvier 2017 à Mai 2020.

Nous allons donc créer 2 séries (appelées aussi GTS)

Soit crnt-revenue.gts:

# 2017

1483225200000000// revenue{company=cerenit} 0

1485903600000000// revenue{company=cerenit} 13800

1488322800000000// revenue{company=cerenit} 11325

1490997600000000// revenue{company=cerenit} 300

1493589600000000// revenue{company=cerenit} 6825

1496268000000000// revenue{company=cerenit} 8450

1498860000000000// revenue{company=cerenit} 5425

1501538400000000// revenue{company=cerenit} 10650

1504216800000000// revenue{company=cerenit} 13650

1506808800000000// revenue{company=cerenit} 0

1509490800000000// revenue{company=cerenit} 11200

1512082800000000// revenue{company=cerenit} 19225

# 2018

1514761200000000// revenue{company=cerenit} 8300

1517439600000000// revenue{company=cerenit} 8850

1519858800000000// revenue{company=cerenit} 10285

1522533600000000// revenue{company=cerenit} 8850

1525125600000000// revenue{company=cerenit} 8850

1527804000000000// revenue{company=cerenit} 9450

1530396000000000// revenue{company=cerenit} 12000

1533074400000000// revenue{company=cerenit} 11250

1535752800000000// revenue{company=cerenit} 15013

1538344800000000// revenue{company=cerenit} 15750

1541026800000000// revenue{company=cerenit} 13750

1543618800000000// revenue{company=cerenit} 10125

# 2019

1546297200000000// revenue{company=cerenit} 15375

1548975600000000// revenue{company=cerenit} 14750

1551394800000000// revenue{company=cerenit} 11600

1554069600000000// revenue{company=cerenit} 20622

1556661600000000// revenue{company=cerenit} 6376

1559340000000000// revenue{company=cerenit} 13350

1561932000000000// revenue{company=cerenit} 11250

1564610400000000// revenue{company=cerenit} 7050

1567288800000000// revenue{company=cerenit} 14750

1569880800000000// revenue{company=cerenit} 12326

1572562800000000// revenue{company=cerenit} 12513

1575154800000000// revenue{company=cerenit} 9082

# 2020

1577833200000000// revenue{company=cerenit} 13000

1580511600000000// revenue{company=cerenit} 12375

1583017200000000// revenue{company=cerenit} 15500

1585692000000000// revenue{company=cerenit} 5525

1588284000000000// revenue{company=cerenit} 15750

et crnt-expenses.gts:

# 2017

1483225200000000// expense{company=cerenit} 219

1485903600000000// expense{company=cerenit} 5471

1488322800000000// expense{company=cerenit} 7441

1490997600000000// expense{company=cerenit} 6217

1493589600000000// expense{company=cerenit} 5676

1496268000000000// expense{company=cerenit} 5719

1498860000000000// expense{company=cerenit} 5617

1501538400000000// expense{company=cerenit} 5690

1504216800000000// expense{company=cerenit} 5831

1506808800000000// expense{company=cerenit} 9015

1509490800000000// expense{company=cerenit} 8903

1512082800000000// expense{company=cerenit} 11181

# 2018

1514761200000000// expense{company=cerenit} 9352

1517439600000000// expense{company=cerenit} 9297

1519858800000000// expense{company=cerenit} 8506

1522533600000000// expense{company=cerenit} 8677

1525125600000000// expense{company=cerenit} 10136

1527804000000000// expense{company=cerenit} 10949

1530396000000000// expense{company=cerenit} 8971

1533074400000000// expense{company=cerenit} 9062

1535752800000000// expense{company=cerenit} 9910

1538344800000000// expense{company=cerenit} 10190

1541026800000000// expense{company=cerenit} 10913

1543618800000000// expense{company=cerenit} 13569

# 2019

1546297200000000// expense{company=cerenit} 11553

1548975600000000// expense{company=cerenit} 11401

1551394800000000// expense{company=cerenit} 10072

1554069600000000// expense{company=cerenit} 10904

1556661600000000// expense{company=cerenit} 9983

1559340000000000// expense{company=cerenit} 11541

1561932000000000// expense{company=cerenit} 11065

1564610400000000// expense{company=cerenit} 10359

1567288800000000// expense{company=cerenit} 10450

1569880800000000// expense{company=cerenit} 9893

1572562800000000// expense{company=cerenit} 10014

1575154800000000// expense{company=cerenit} 15354

# 2020

1577833200000000// expense{company=cerenit} 9673

1580511600000000// expense{company=cerenit} 9933

1583017200000000// expense{company=cerenit} 9815

1585692000000000// expense{company=cerenit} 9400

1588284000000000// expense{company=cerenit} 9381

Pour chaque fichier:

- le premier champ est un timestamp correspondant au 1er jour de chaque mois à 00h00.

- la partie

//indique qu’il n’y a pas de position spatiale (longitude, lattitude, élévation) expenseetrevenuesont les noms des classes qui vont stocker mes informationscompanyest un label que je positionne sur mes données avec le nom de mon entreprise- le dernier champ est la valeur de mon chiffre d’affaires ou de mes dépenses mensuels.

Pour plus d’information sur la modélisation, cf GTS Input Format.

Insertion des données

Lorsque vous utilisez la Sandbox, 3 tokens vous sont donnés :

- un token pour lire les données ; j’y ferai référence via

<readToken>par la suite - un token pour écrire les données ; j’y ferai référence via

<writeToken>par la suite - un token pour supprimer les données ; j’y ferai référence via

<deleteToken>par la suite

#!/usr/bin/env bash

for file in crnt-expenses crnt-revenue ; do

curl -v -H 'Transfer-Encoding: chunked' -H 'X-Warp10-Token: <writeToken>' -T ${file}.gts 'https://sandbox.senx.io/api/v0/update'

done

Premières requêtes

Pour ce faire, nous allons utiliser le Warp Studio ; pour la datasource, il conviendra de veiller à ce que la SenX Sandbox soit bien sélectionnée.

L’équivalent de “SELECT * FROM *” peut se faire de la façon suivante :

# Authentification auprès de l'instance en lecture

'<readToken> 'readToken' STORE

# FETCH permet de récupérer une liste de GTS, ici on demande toutes les classes via ~.* et tous les labels en prenanr les 1000 dernières valeurs ; on récupère donc toutes les séries.

[ $readToken '~.*' {} NOW -1000 ] FETCH

Si vous cliquez sur l’onglet “Dataviz”, vous avez alors immédiatement une représentation graphique de vos points.

Maintenant que nos données sont bien présentes, on va vouloir aller un peu plus loin dans nos manipulations.

Premières manipulations

Ce que nous voulons faire :

- Sélectionner chaque série et la stocker dans une variable,

- Calculer le résultat mensuel et le persister dans une troisième série temporelle

- Afficher les trois séries.

Pour sélectionner chaque série et la stocker dans une variable:

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# FETCH : permet de récupérer une liste de série, ici on filtre sur la classe expense, sur le label company = cerenit et sur les dates du 01/12/2016 au 01/06/2020.

# 0 GET : on sait que l'on a qu'une seule série qui correspond à la requête. Donc on ne retient que le 1er élément pour passer d'une liste de GTS à une seule et unique GTS.

# STORE : stocke le résultat dans une variable exp.

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

# Idem pour la classe revenue, stockée dans une variable revenue.

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

# Affiche les 2 séries

$exp

$revenue

A ce stade, vous avez la même représentation graphique que précédemment si vous cliquez sur Dataviz.

Calculons maintenant le résultat mensuel (chiffre d’affaires - dépenses) :

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Le même bloc que précédemment

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

# Calcul: il suffit se soustraire les deux éléments pour avoir le résultat

$revenue $exp -

# on affiche également les deux autres variables pour la dataviz

$exp

$revenue

A ce stade :

- Au niveau de la dataviz, la légende ne fournit aucune information sur la nature de la série

- Cette donnée n’est pas encore persistée

Jusqu’à présent, nous avons utilisé que le <readToken> pour lire les données. Pour la persistence, nous allons utilier le <writeToken>.

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Authentification auprès de l'instance en écriture

'<writeToken>' 'writeToken' STORE

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

# La première ligne est inchangée, elle calcule le résultat mensuel et la donnée est de type GTS

# Du coup, comme nous sommes dans une pile et que l'on hérite de ce qu'il s'est passé avant, on peut lui assigner un nom via RENAME

# Puis lui ajouter le label company avec pour valeur cerenit

# Et utiliser la fonction UPDATE pour stocker en base la GTS ainsi obtenue.

$revenue $exp -

"result" RENAME

{ "company" "cerenit" } RELABEL

$writeToken UPDATE

# Comme pour revenue et expense, on récupère les données sous la forme d'une GTS que l'on stocke dans une variable

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

# On vide la pile

CLEAR

# On affiche les variables créées

$revenue

$exp

$result

Et voilà !

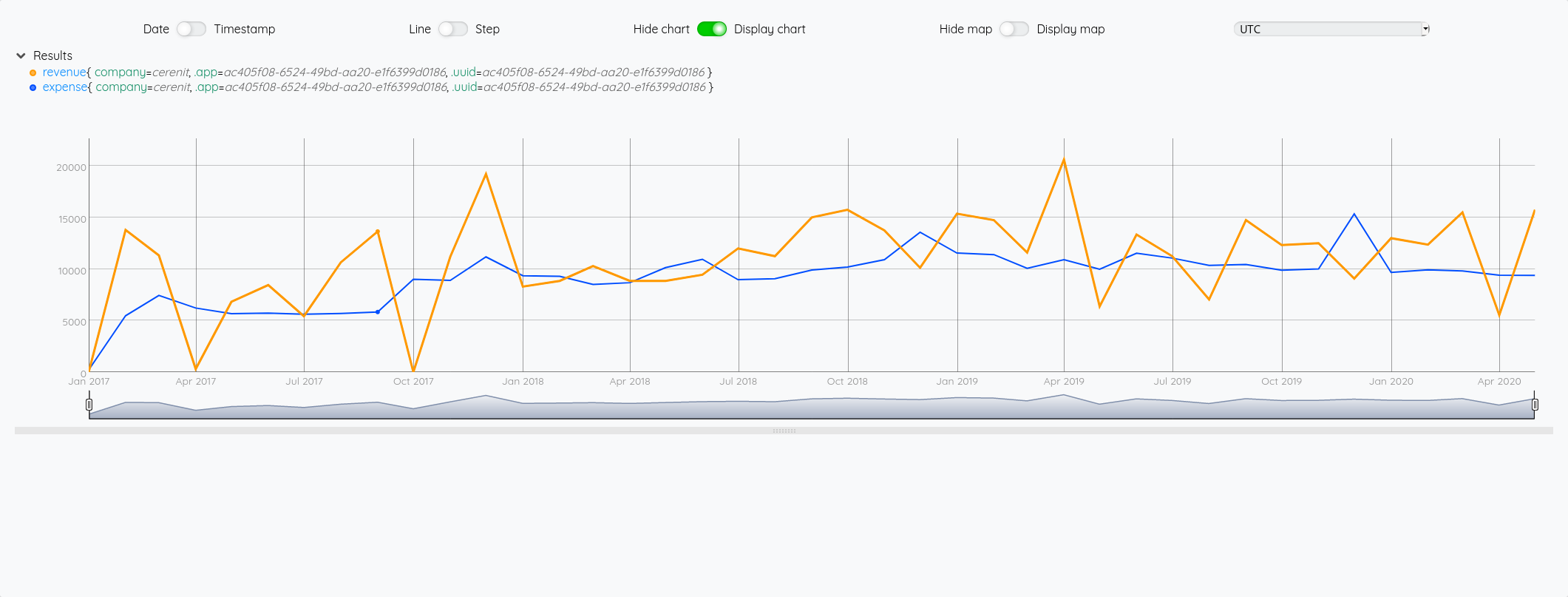

Prévoyons le futur

Warp10 dispose d’une extension propriétaire et payante permettant d’appliquer des algorithmes de prévisions sur des séries temporelles : warp10-ext-forecasting. Il est possible d’utiliser cette extension sur la Sandbox Warp10 mise à disposition par SenX.

Il existe une fonction AUTO et SAUTO (version saisonnière) qui applique automatiquement des algorythmes d’AutoML sur vos données.

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Récupération des trois séries

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

CLEAR

$revenue

$exp

$result

# MAP: la fonction `AUTO` s'attend à manipuler des nombres au format `DOUBLE` et non des entiers. Il faut donc faire la conversion.

# FORECAST: sur les données obtenues du MAP, on applique la fonction AUTO et on demande les 8 prochaines occurents (pour aller jusqu'à la fin d'année)

# Le .ADDVALUES permet de "fusionner" les prévisions avec la série parente (sans les persister en base à ce stade)

# Commes les 3 projections sont disponibles dans la pile, elles sont également affichées

[ $result mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

Du fait du FORECAST.ADDVALUES, on pourrait se passer d’afficher les trois premières séries. Mais vistuellement, cela permet de voir la différence entre la série originale et la projection.

Une fois l’effet Whaou passé, on peut se demander quel modèle a été appliqué. Pour cela il y a la fonction MODELINFO

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Récupération des trois séries

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

CLEAR

[ $result mapper.todouble 0 0 0 ] MAP

AUTO MODELINFO

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO MODELINFO

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO MODELINFO

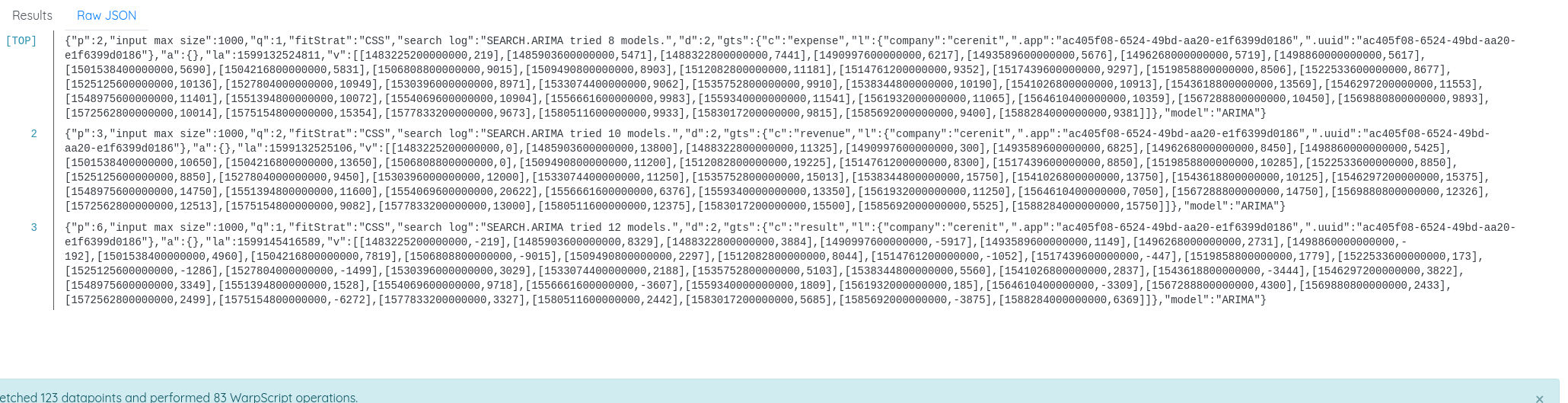

Dans l’onglet des résultats, on voit l’information: "model": "ARIMA".

Si on veut alors faire la même chose en utilisant le modèle ARIMA :

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

# Récupération des trois séries

[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

CLEAR

# SEARCH.ARIMA: applique un modèle ARIMA (ARMA ou ARIMA) sur la GTS passée en paramètre

# FORECAST.ADDVALUES: fait une précision sur les 7 prochaines occurences et les fusionne avec la série sur laquelle la projection est faite.

# Les 3 projections restant dans la pile, elles sont affichées

[ $revenue mapper.todouble 0 0 0 ] MAP

SEARCH.ARIMA

7 FORECAST.ADDVALUES

[ $exp mapper.todouble 0 0 0 ] MAP

SEARCH.ARIMA

7 FORECAST.ADDVALUES

[ $result mapper.todouble 0 0 0 ] MAP

SEARCH.ARIMA

7 FORECAST.ADDVALUES

Et nous obtenons bien le même résultat.

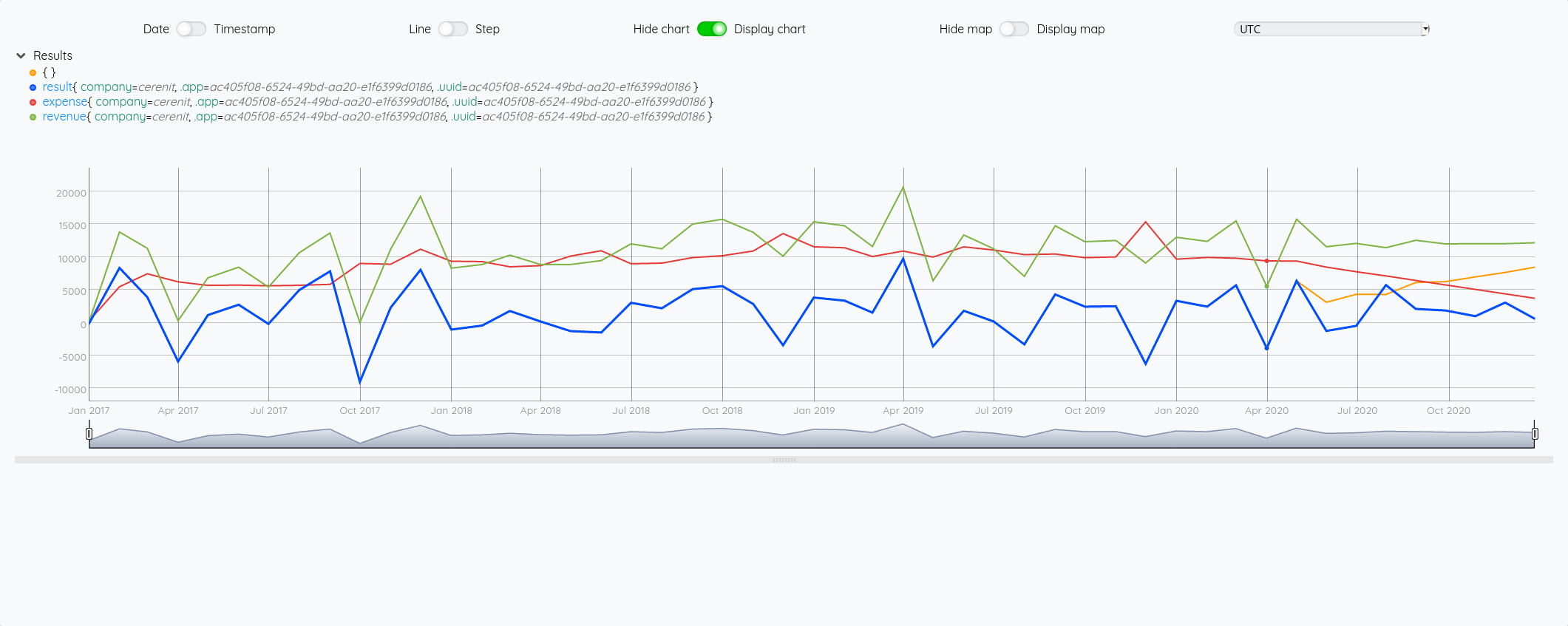

On peut se poser alors la question de voir si la projection sur le résultat est la même que la soustraction entre la projection de chiffres d’affaires et de dépenses et mesurer l’éventuel écart.

# Authentification auprès de l'instance en lecture

'<readToken>' 'readToken' STORE

[[ $readToken 'expense' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'exp' STORE

[ $readToken 'revenue' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'revenue' STORE

[ $readToken 'result' { 'company' '=cerenit' } '2016-12-01T00:00:00Z' '2020-06-01T00:00:00Z' ] FETCH

0 GET

'result' STORE

CLEAR

# La différence sur les 3 projections est que l'on stocke chaque résultat dans une variable

[ $result mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

'fresult' STORE

[ $revenue mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

'frevenue' STORE

[ $exp mapper.todouble 0 0 0 ] MAP

AUTO 8 FORECAST.ADDVALUES

'fexp' STORE

$frevenue

$fexp

$fresult

# ici on calcule la projection du résultat sur la base des projections de chiffres d'affaires et de dépenses

$frevenue $fexp -

On constate bien un écart entre la courbe orange (la soustraction des projections) et la courbe bleu (la projection du résultat).

Nous voilà à la fin de ce billet, j’espère que ce tour du propriétaire vous aura permis d’apprécier Warp10 et ses capacités.

Il ne reste plus qu’à voir en fin d’année dans quelles mesures ces projections seront valides ou pas !

Mon bilan sur Warp10 à ce stade :

- Il faut absolument suivre le tutoriel sur les cyclones, cela permet de se mettre progressivement à Warpscript et de comprendre les mécanismes de fonctionnement du langage et de la pile (stack).

- la notation de Warpscript est particulière au début mais on s’y fait petit à petit et sinon FLoWS devrait lever les dernières réticences.

- Comme on a une pile, il ne faut pas hésiter à utiliser

STOPetTYPOEOFnotamment pour savoir ce que l’on manipule comme donnée à un instant T ; cf Debugging WarpScript - Le WarpStudio ou l’extension VSCode permettent d’avoir un contexte de développement agréable avec l’autocomplétion, la documentation des fonctions, etc.

- Contrairement à InfluxDB où tout s’articule autour du measurement (équivalent de la classe ici), le fait d’avoir un langage de manipulation (et pas principalement de requêtage avec quelques transformations) de données permet d’avoir une modélisation plus souple et de réconcilier les données ensuite. Le même exercice dans InfluxDB supposerait d’avoir un seul measurement et d’avoir les différentes valeurs en son sein. Du coup, cela empêcherait le calcul et le stockage du résultat par ex. Il aurait fallu le calculer au préalable et l’insérer dans la base en même temps que les données de chiffre d’affaires et de dépenses pour que les données soient ensemble. Certes Flux et InfluxDB 2.0 vont lever quelques contraintes de modélisation et de manipulation de données, mais le prisme de la modélisation autour du measurement reste primordial dans le produit.

- Avoir un langage de manipulation de données et non uniquement de requêtage et quelques transformation évite aussi de devoir sortir les données pour les analyser puis les renvoyer vers la base de données le cas échéant. Non seulement on reste au plus près de la donnée (éxécution coté serveur) mais on évite aussi les problématiques de drivers, conversion dans les structures de données du langage cible, etc.

- Les classes de warpscript sont certes mono valeurs (même si le multivalue existe) mais je présume que cela sert surtout pour des données de même nature plutôt que pour des données hétérogènes. En effet, il s’agit d’une liste et non d’un tableau de données. (NDLR: Mathias me précise qu’une multivalue est une GTS et non une simple liste - cela est précisé si on lit bien la totalité de la doc de multivalue)

Une expérience au final positive qui pousse à aller creuser plus loin les fonctionnalités de cette plateforme. Ce sera l’opportunité de rédiger d’autres billets à l’avenir.

Web, Ops & Data - Juin 2020

terraform telegraf kubernetes operator rancher longhorn raspberrypi prometheus victoria-metrics monitoring influxdb warp10 forecastJe ne peux résister à mentionner la sortie de l’épisode 100 du BigDataHebdo, podcast où j’ai le plaisir de contribuer. Pour ce numéro spécial (épisode 100 et 6 ans du podcast), nous avons fait appel aux membres de la communauté pour partager avec nous leur base de données favorite, la technologie qui les a le plus impressionée durant ces 6 dernières années et celle qu’ils voient comme majeure pour les 6 prochaines années. Allez l’écouter !

Cloud

- Announcing the Terraform Visual Studio Code Extension v2.0.0 : Hashicorp prend en main le support de l’extension Terraform pour VSCode, en sort une nouvelle version et apporte différentes améliorations comme un meilleur support de Terraform 0.12 et l’utilisation du Terraform Language Server.

Container et orchestration

- Introducing the Telegraf Operator: Kubernetes Sidecars Made Simple : Présentation de l’operator kubernetes pour telegraf qui permet de déployer un agent telegraf sous la forme d’un sidecar dans un pod et de récupérer les métriques associés.

- Kubernetes 1.18.x officiellement disponible chez OVHCloud

- Longhorn Simplifies Distributed Block Storage in Kubernetes : Rancher vient de sortir la version 1.0 de Longhorn. C’est une solution de stockage pour Kubernetes que l’on peut utiliser avec ou sans Rancher. Il faut la voir comme une solution de stockage légère et simple à mettre en oeuvre. Un système de réplication permet d’éviter les pertes de données et d’amélioer la durabilité des données. Des fonctionnalités de backup/restore existent également. Elle semble plus simple à mettre en oeuvre que Rook/Ceph par ex mais sera moins complète que ce dernier.

- Understanding Kubernetes & Understanding Istio : Aurélie Vache réalise des sketchnotes pour vulgariser Kubernetes et Istio. Un joli travail de vulgarisation.

IoT

- 8GB Raspberry Pi 4 on sale now at $75 : Le Raspberry Pi 4 arrive en version 8Go de RAM, Raspberry PI OS arrive en 64 bits, le support du boot sur usb arrive aussi (adieu la SDCard) et plein d’autres choses. Le tout au prix de 75$.

Ops

- Sismology: Iguana Solutions’ Monitoring System : retour d’expérience sur une plateforme de monitoring initiée sur Prometheus et qui évolue vers VictoriaMetrics en prenant les aspects de stockage à long terme, le multi-tenant et la haute disponibilité de la plateforme.

Time Series

- Release Announcement: InfluxDB 2.0.0 Beta 12 : une beta de plus avec l’ajout notamment d’

influx stackspour faire du CRUD sur des groupes de ressources InfluxDB (dashboard, labels, tasks, etc). - Warp 10, The Most Advanced Time Series Platform, now provides multi-architecture docker images. : vous pouvez donc déployer des images docker warp10 sur des plateformes amd64/armv7/arm64.

- May 2020: Warp 10 release 2.6.0 : Pleins d’améliorations et de correctifs et notamment la capacité de dialoguer directement avec Warp10 via le protocole Protobuf ou via Arrow.

- Time series forecasts in WarpScript : Présentation de l’extension Warpscript permettant d’appliquer des algorithmes de prévisions (ARIMA, SARIMA, HOLTWINTERS, etc) sur des séries temporelles. Précision: il s’agit d’une extension propriétaire mais vous pouvez l’évaluer sur la sandbox Warp10 mise à disposition par SenX.